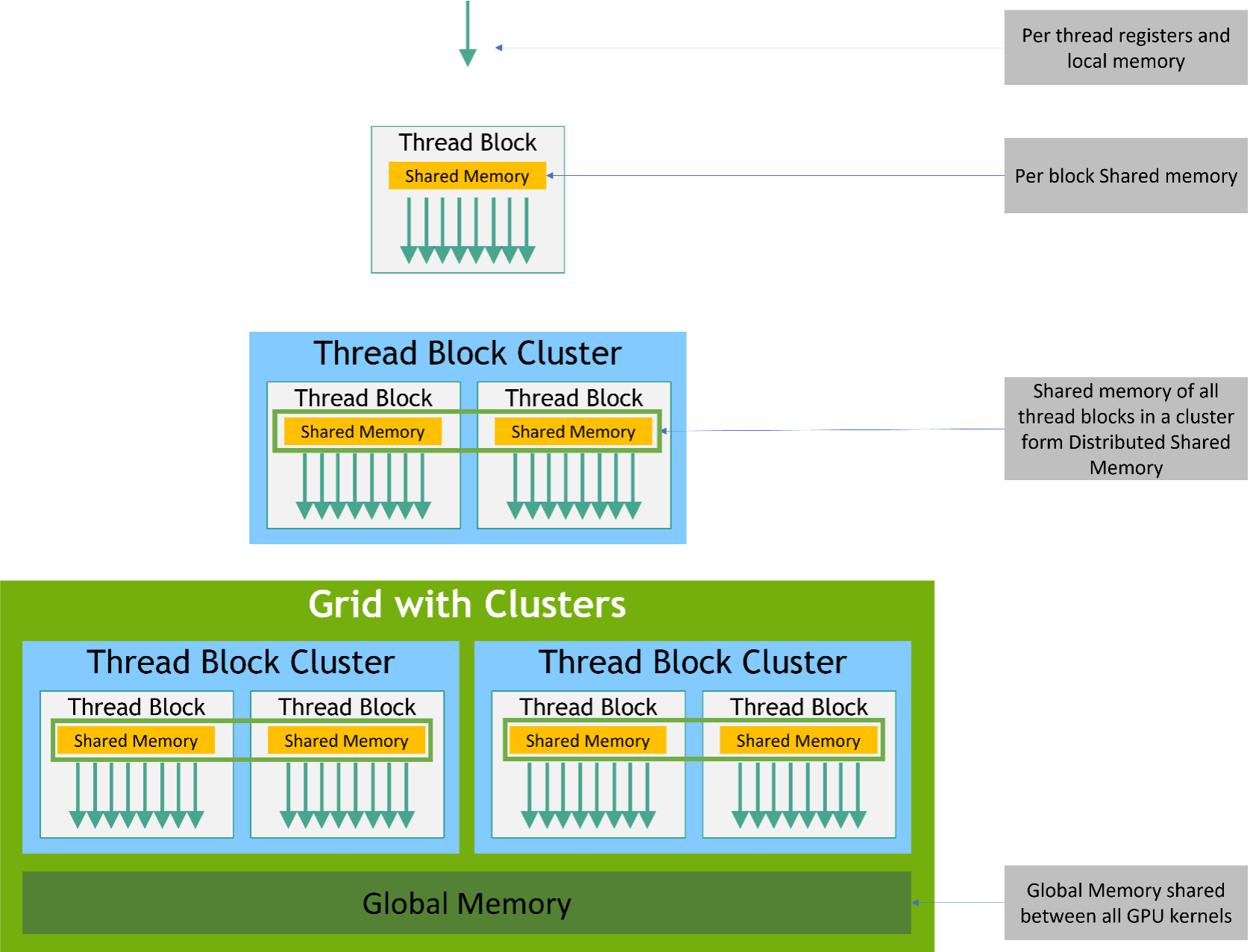

Memory Hierarchy

Memory Hierarchy

Memory Hierarchy

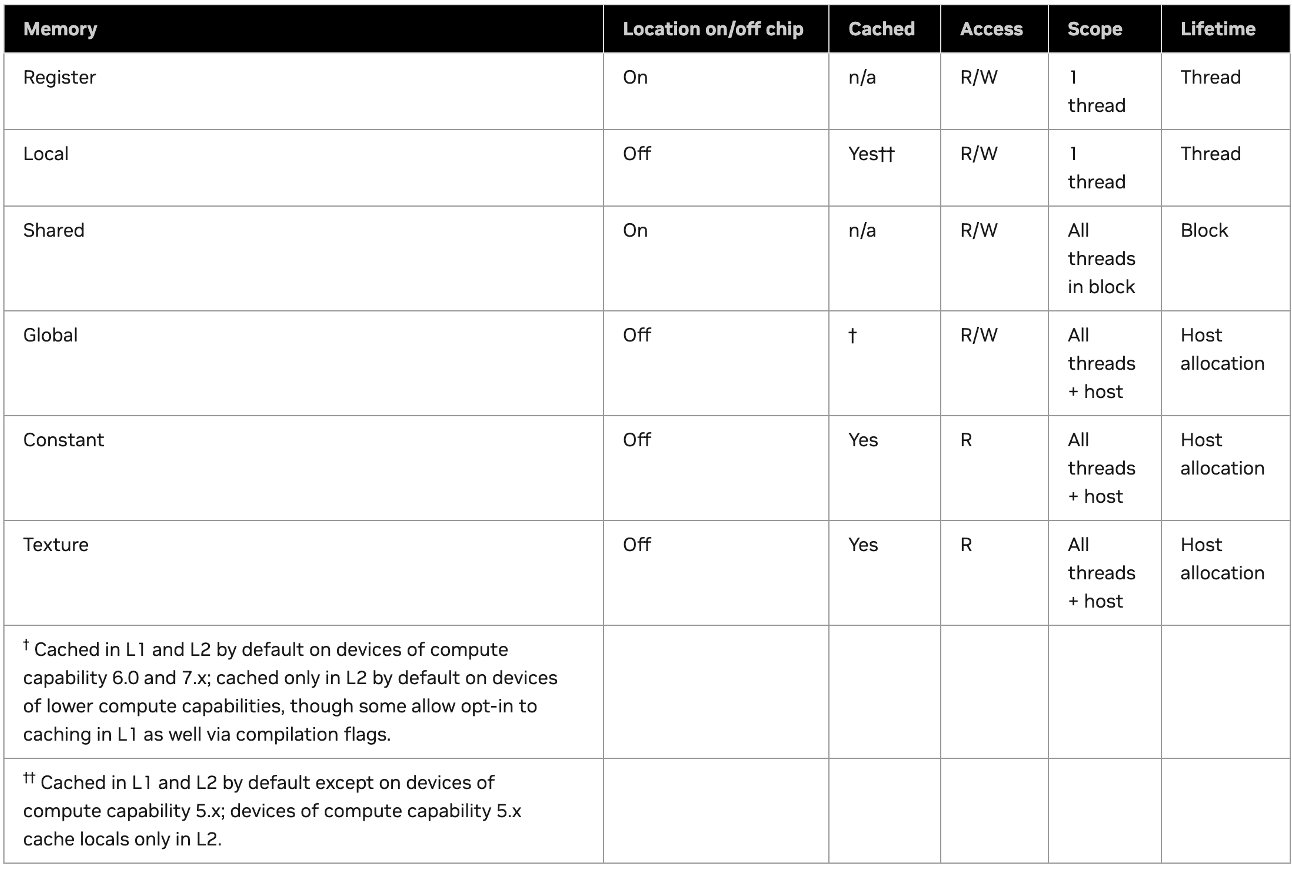

Memory补充说明

- on-chip memory:包括 register 和 shared memory,所有的 on-chip memory 都是 SRAM

- off-chip memory:包括 global、local、constants、texture memory,所有的 off-chip memory 都是 DRAM

- Global Memory 中访问的数据总是会被缓存到 L2 中,当满足一些更严格的条件时会进一步被缓存到 L1 中

- GPU DRAM 的大小 = off-chip memory 的大小 = "显存"

Memory补充说明

- High Bandwidth Memory(HBM):可以认为指的就是 DRAM

- L1 cache 和 shared memory 共享一块 on-chip memory,所以我们可以认为这两者的访问速度相同

- cache 是程序员无法控制的,但 shared memory 可以

从 GPU 基础到 FlashAttention

- FlashAttention 的核心目标是把 Q/K/V 的计算尽量留在 register 与 shared memory,减少对 global memory(HBM)的往返

- 线程/warp 的组织方式决定了一个 tile 在 GPU 上的执行效率,因此我们需要关注 warp 内的同步与分支

- 后续的 FlashAttention 章节会结合 tiling、online softmax 等技巧,展示如何把刚才的 GPU 基础概念映射到 attention 的计算

FlashAttention

- Installation

- GPU Basics

- FlashAttention V1

- FlashAttention V2

- Other

Basic Info

- 效果:FlashAttention 可以加速 Attention Layer 在训练和推理过程中的计算速度,并且保证计算结果准确

- 动机: Transformer 架构的计算时间开销大,此开销和访存代价有关

- 原理:减少存储访问开销,这与绝大数减少计算时间复杂度方法的原理是不一样的

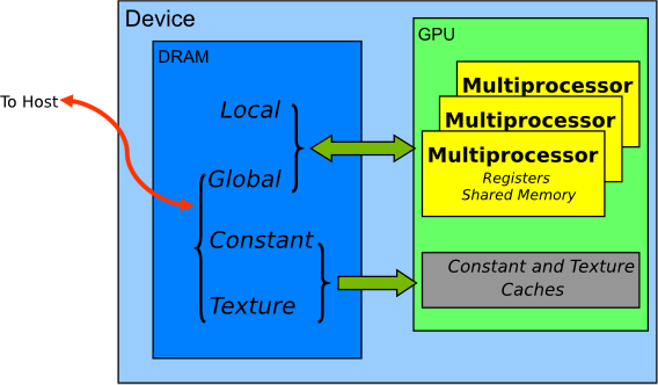

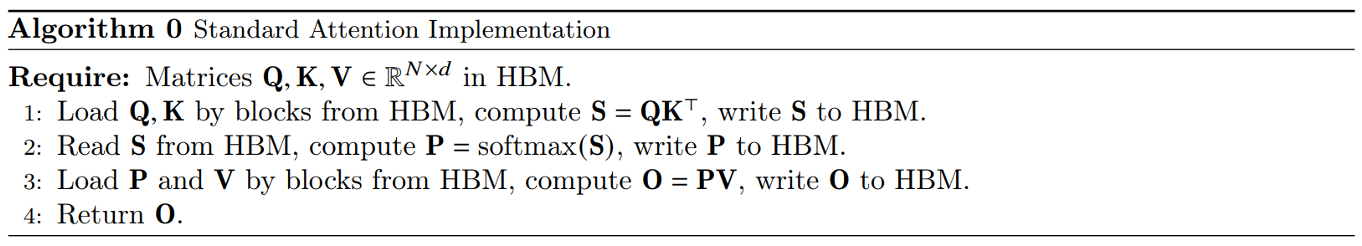

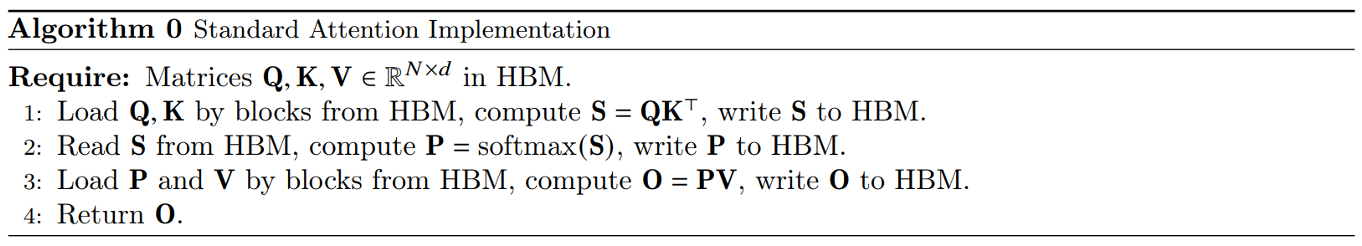

标准 Self Attention

- 在这个过程中,一共包含了 8 次需要访问 HBM 的操作

- 第 1 行:读 Q、K,写 S

- 第 2 行:读 S,写 P

- 第 3 行:读 P、V,写 O

- HBM 访问成本:

优化维度

- 一种思路是:减少每一步中实际访问 HBM(global memory)的次数

- 或者:调整算法步骤,减少整体流程上访问 HBM 的次数

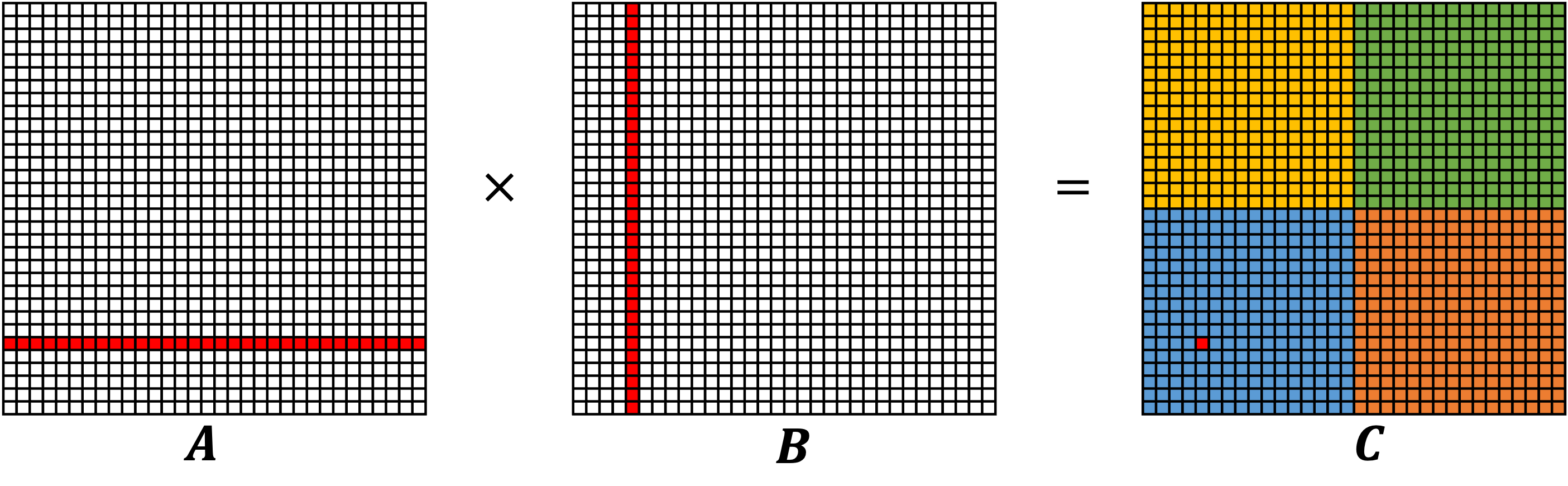

从 block 出发思考问题

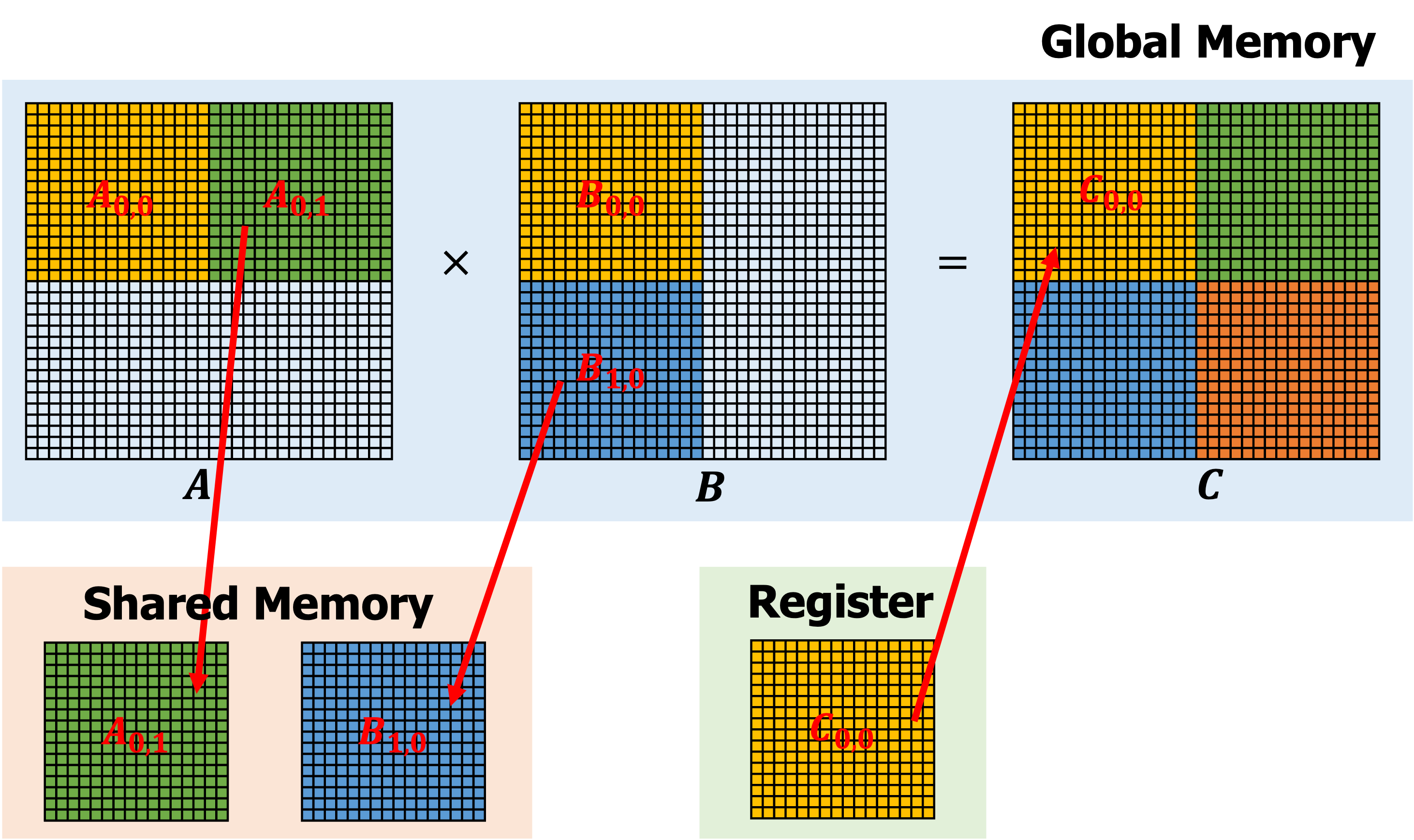

- 以矩阵乘法 𝑪=𝑨×𝑩 为例,在实际的计算过程中,线程会被组织成 block,再交由 SM 执行

- 以 𝑪 为 32*32 的矩阵,block 为 16*16 为例,一种朴素的实现方法:

- C 中每个位置的计算需要访问 global memory 2*32 次,总共 2*32*32*32 次

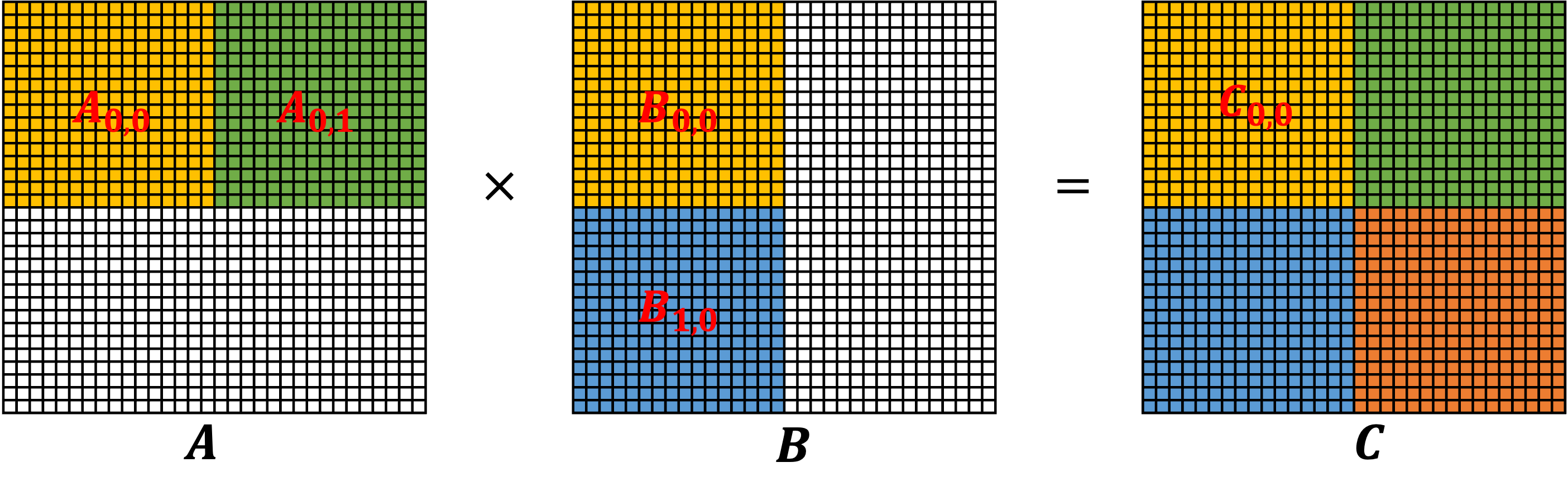

Tiling 技术

- 在朴素的实现方法中,我们并没有考虑利用 shared memory,而 Tiling 技术通过利用 shared memory 减少 global memory 的访问

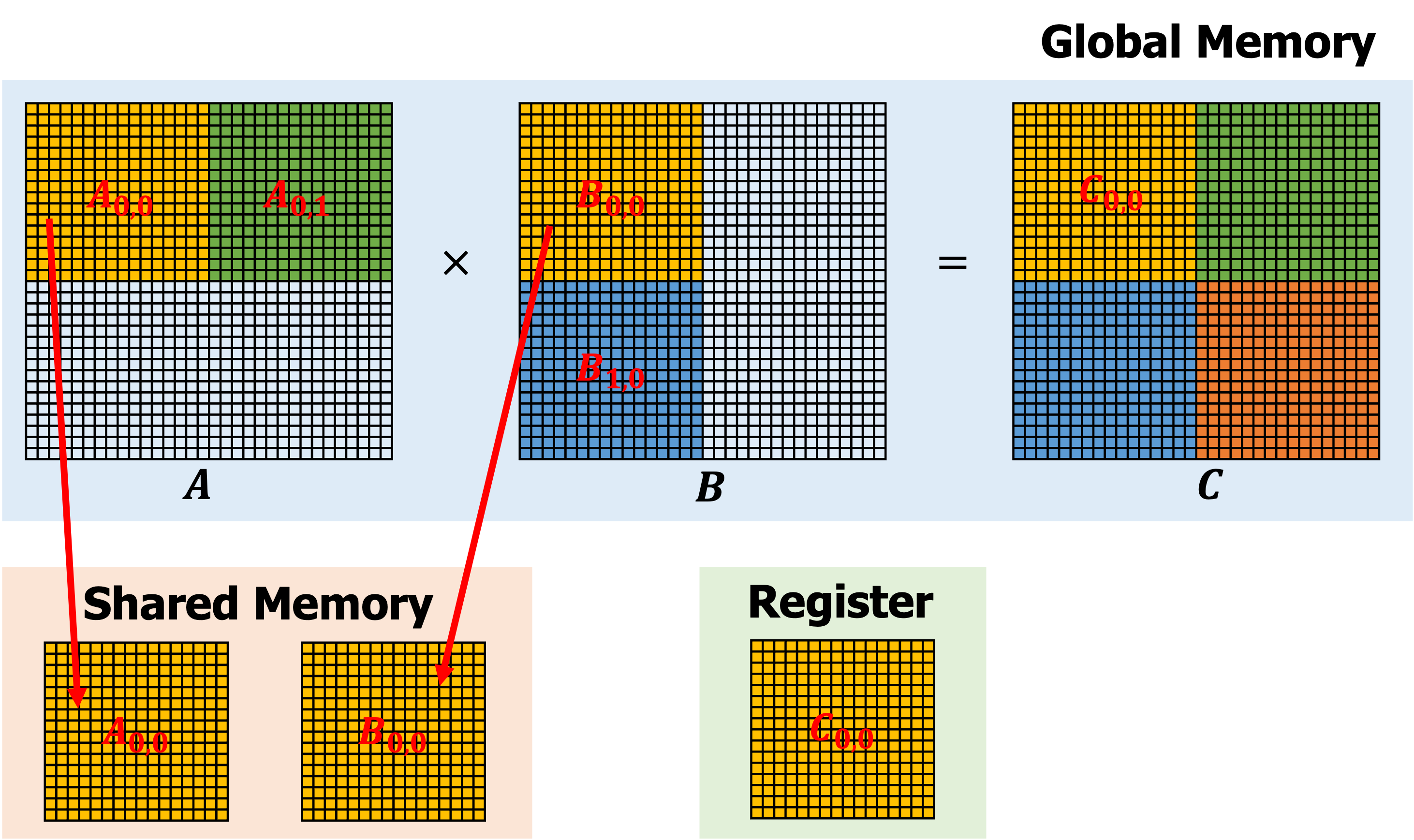

Tiling 技术 (cont'd)

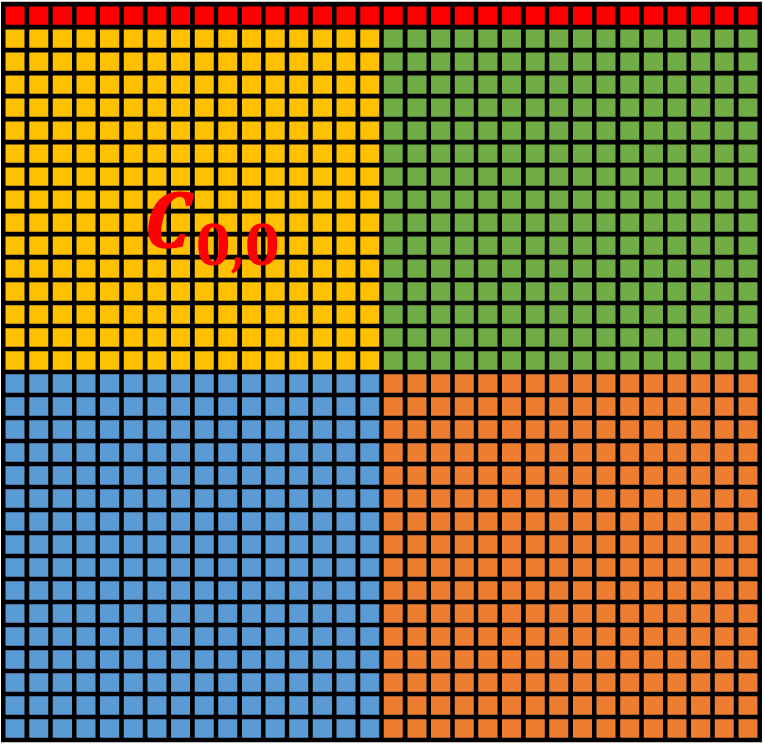

- 第一轮迭代存储角度图示:

Tiling 技术 (cont'd)

- 第二轮迭代存储角度图示:

Tiling 技术 (cont'd)

- 总计算量保持不变

- 但是总的 global memory 的访问次数大大降低,我们算出 C 矩阵四分之一的结果时,访问了 16*16*4 次 global memory,那么总共将访问 16*16*4*4 次,一共 4096 次;而之前 naive 的方法访问了 65536 次,减少为了原来的 1/16

- 调整 block 的大小还可以进一步改变 global memory 的访问次数

Unfortunately

- Tiling 技术虽然可用于矩阵乘法,但不能直接用于 Attention 的计算

- 在 Attention Layer 的计算中,存在一次 row-wise softmax 操作

- 在 Attention Layer 的计算中,存在一次 row-wise softmax 操作

- 在仅计算出

Unfortunately

- 因此 Tiling 技术仅仅减少了标准 Attention 算法中矩阵乘法的实际 global memory 访问次数,但是并没有从整体上改变标准 Attention 算法的流程

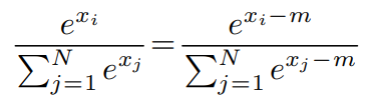

Safe Softmax

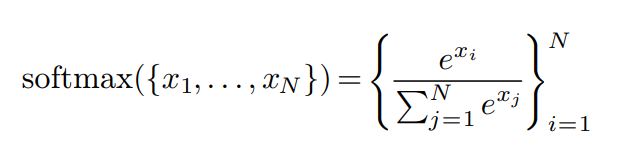

Softmax 的公式:

为了防止指数爆炸问题,在实际计算的时候会采用 Safe Softmax:

一般来说,上述公式中

Softmax 的数学本质

- 常见用途

- 注意力机制中的权重计算(如

- 分类模型输出层,把 logits 转换为类别概率

- 注意力机制中的权重计算(如

Softmax 的数值风险

- 直接计算

- 溢出会产生

inf,下溢会得到 0,最终 softmax 可能变成NaN

LogSumExp (LSE) 与稳定形式

- 定义:

- 稳定化:令

- 所有

- 所有

LSE 在 Softmax 中的作用

- 归一化因子:

- 数值稳定性:通过引入

- 梯度友好:

- FlashAttention 的 online softmax 正是维护

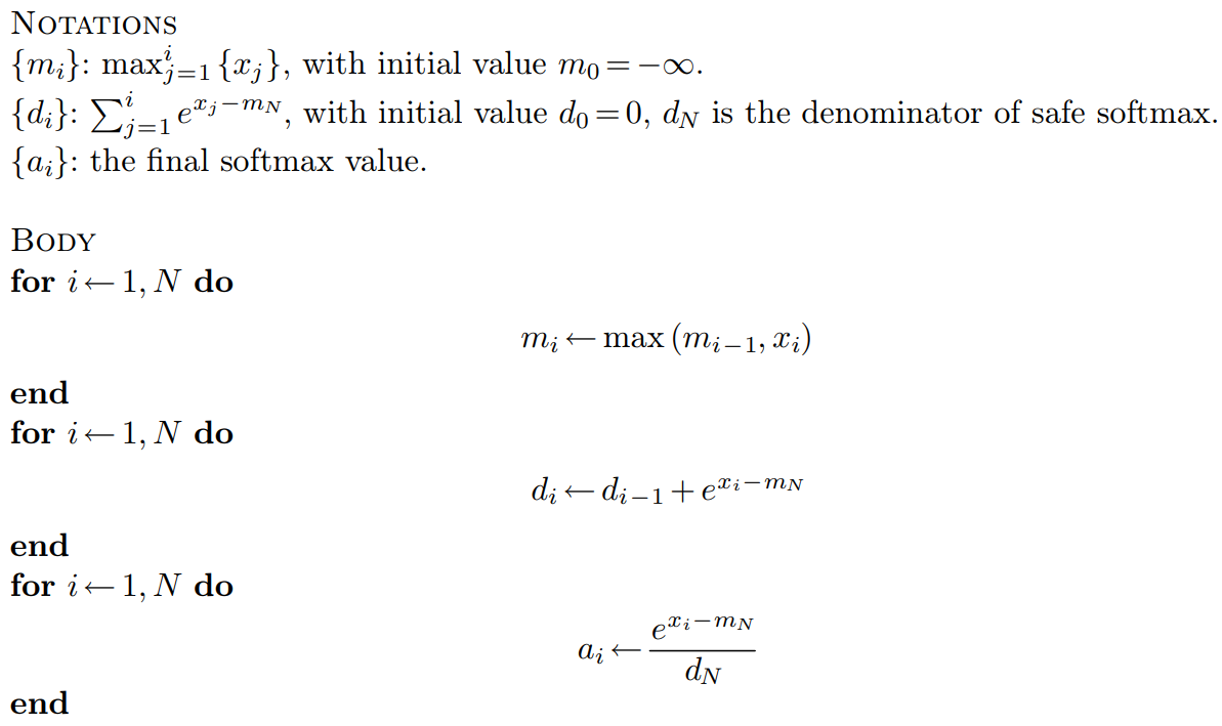

一种迭代式的 Safe Softmax 的算法(V1)

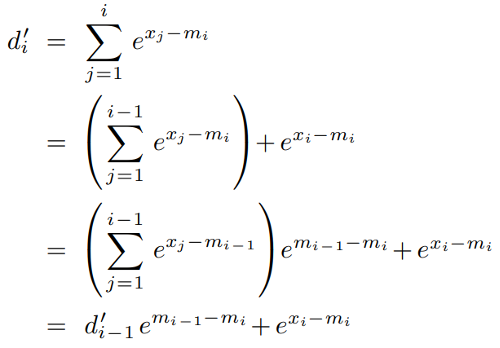

Online Softmax(V2)

- 优化思路:消除

Online Softmax(V2)

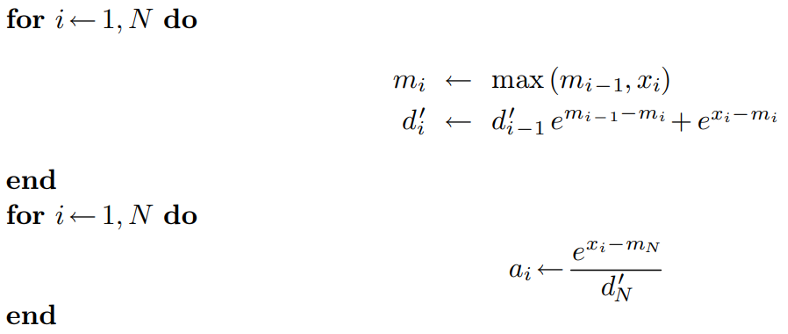

V2版本算法

Again, Unfortunately

- 以上优化对于 softmax 操作来说已经到头了,我们不可能在一次循环中把 softmax 的结果计算出来

- 原因:向量中的每个元素都是独立的,不可能在没有遍历到后续元素的情况下,确定当前元素最终的 softmax 值

But

- Attention Layer 的最终目的并不是为了计算 softmax,而是 softmax 以后的还需要乘以矩阵 V,得到最终的输出

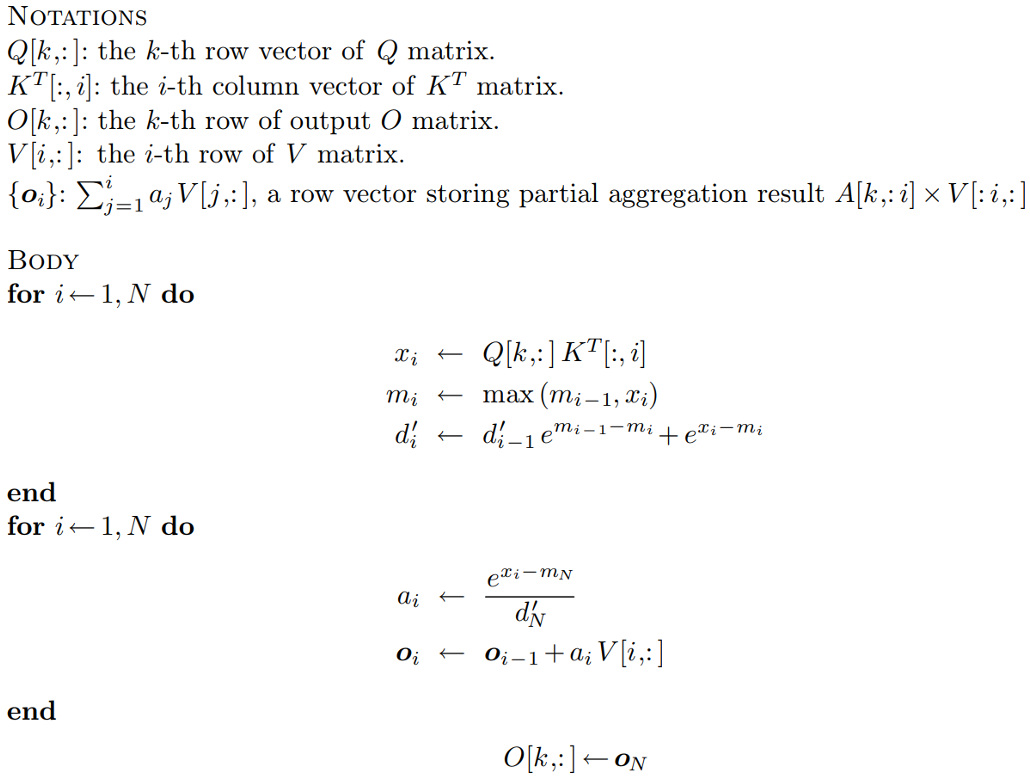

一种 2-pass 的 Self Attention 的算法(V1)

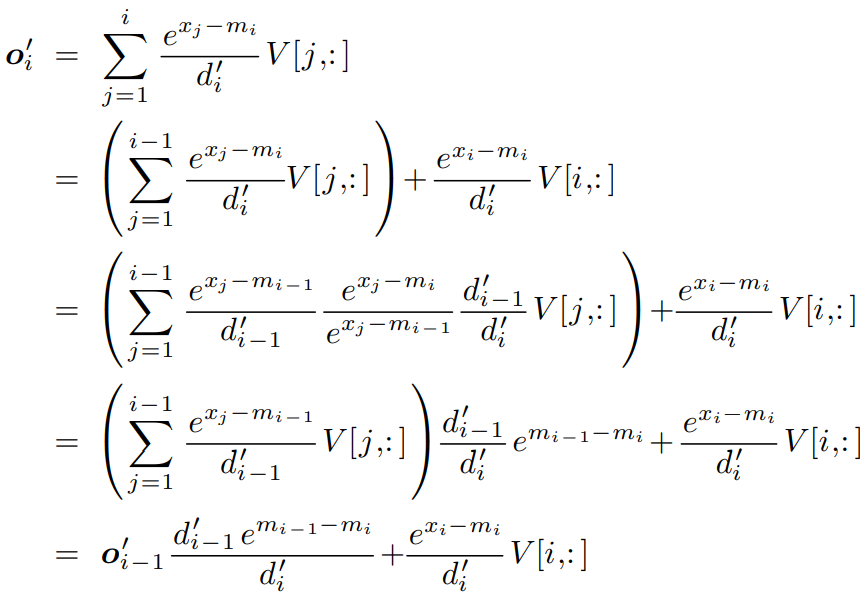

改良版的 1-pass 算法(V2)

改良版的 1-pass 算法(V2)(cont'd)

- 虽然 softmax 无法用 1-pass 的方式解决,但是 Self Attention 的计算可以用1-pass的方式解决

- 以上1-pass Self Attention 算法可看作 FlashAttention V1 的原型

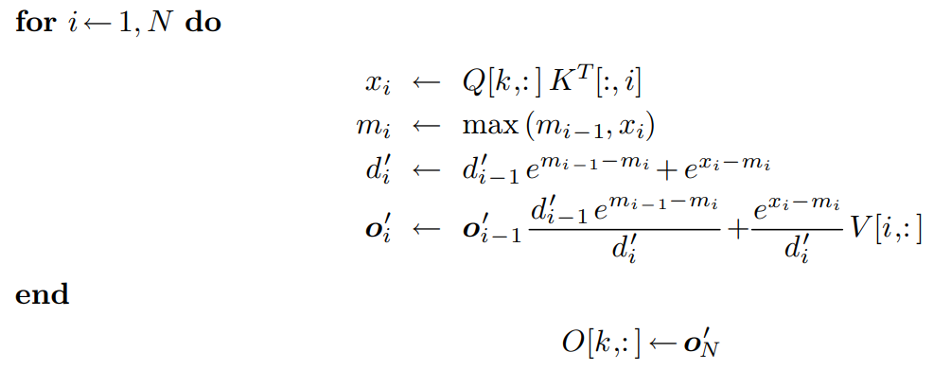

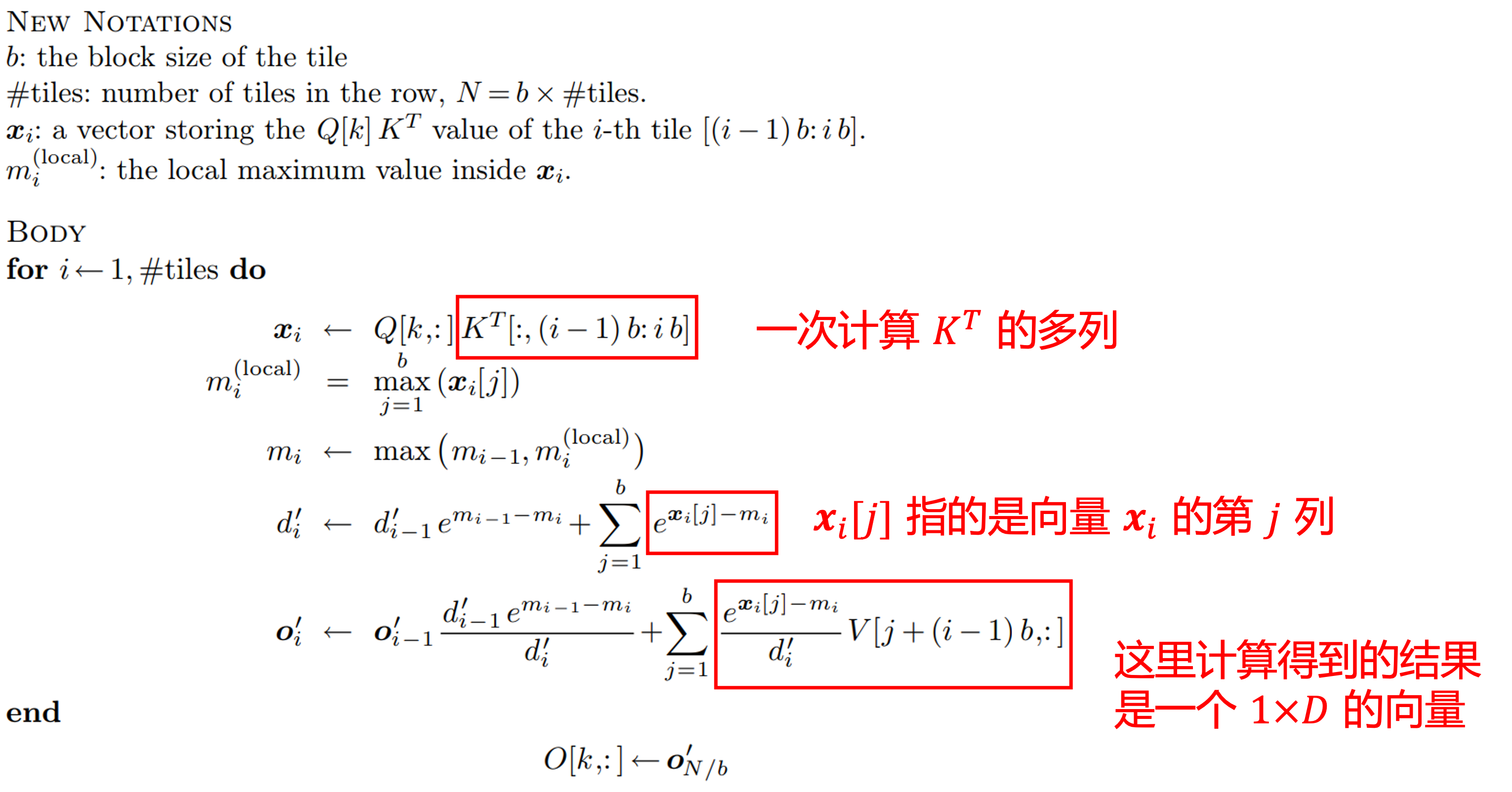

FlashAttention V1

- FlashAttention 在实现时,还考虑到了 Tiling 技术

FlashAttention V1

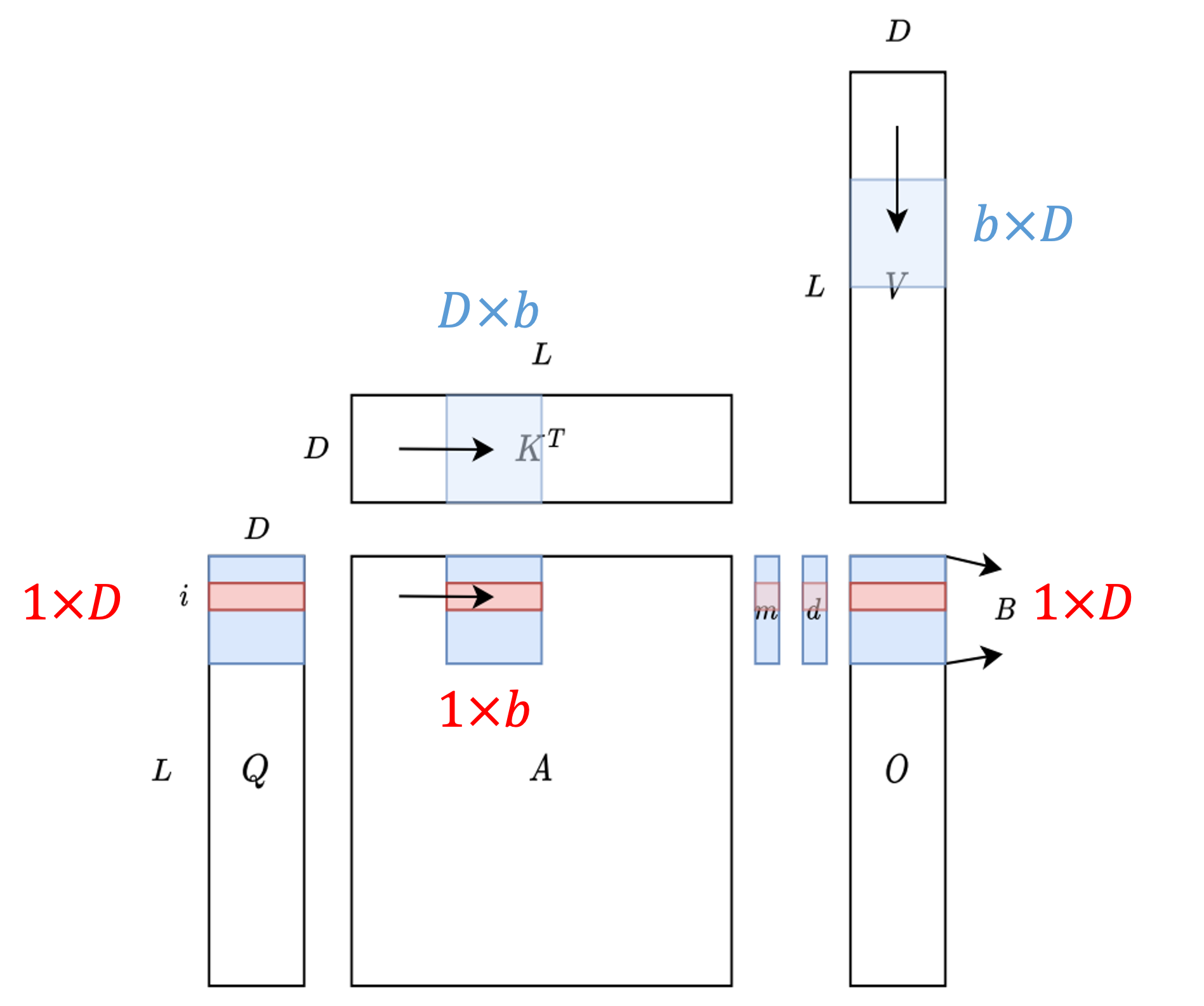

如下图所示,蓝色的部分表示当前存储在 shared memory 中的部分

FlashAttention 的实现是不唯一的,事实上,很多实现都没有完全采用原始论文中的方法,会有一定程度的调整

FlashAttention

- Installation

- GPU Basics

- FlashAttention V1

- FlashAttention V2

- Other

改进一:调整内外循环

- FlashAttention V1 中采用了一个非直觉的外层循环矩阵 𝐾,𝑉,内层循环矩阵 𝑄,𝑂 的方式,这会导致矩阵 𝑂 被额外加载

- 事实上,在 FlashAttention V2 出来之前,很多 FlashAttention 的实现就修改了这个循环顺序

改进二:减少了非矩阵乘法的运算次数

- 现代 GPU 对矩阵乘法有专门的硬件优化,矩阵乘法flop是非矩阵乘法flop的16倍左右

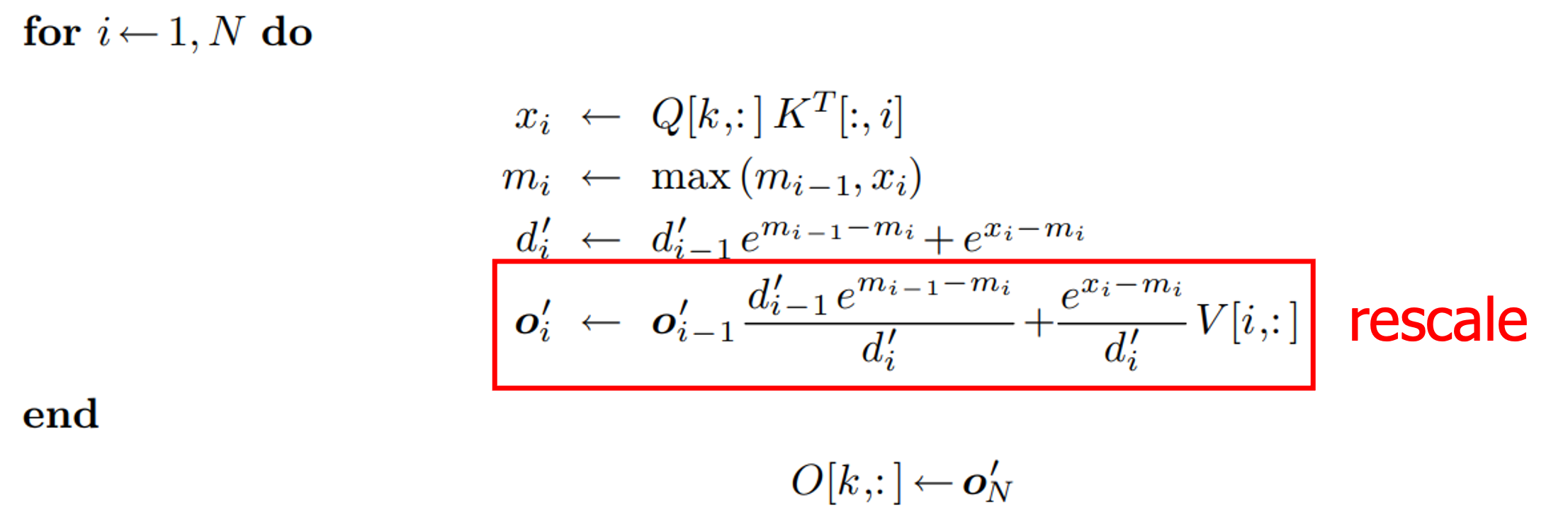

- 具体实现上,FlashAttention V1 每轮迭代都有一个 rescale 操作:

- 具体实现上,FlashAttention V1 每轮迭代都有一个 rescale 操作:

- 在 V2 中,不再在每轮迭代中都除以

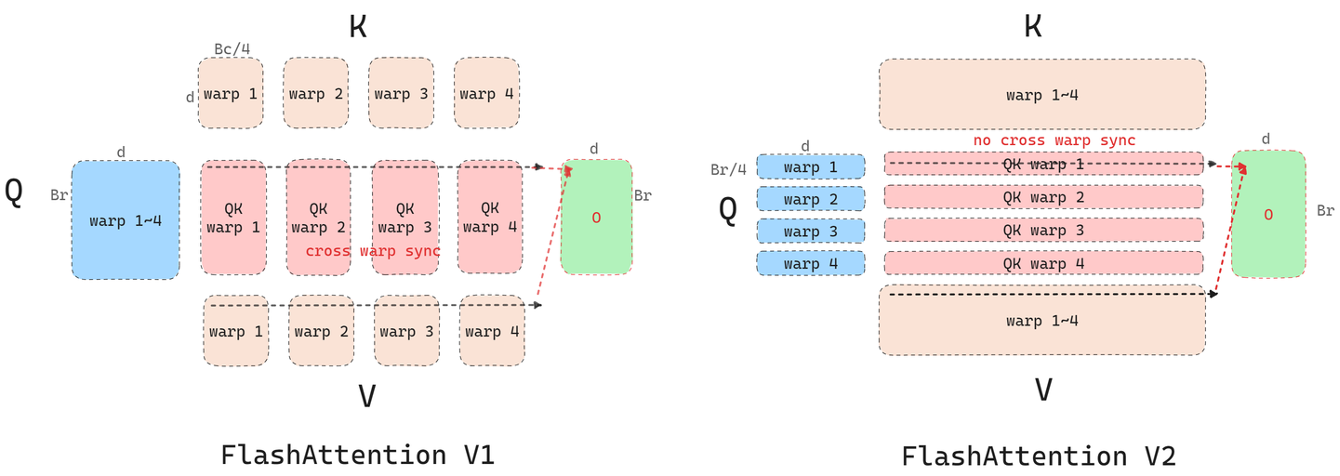

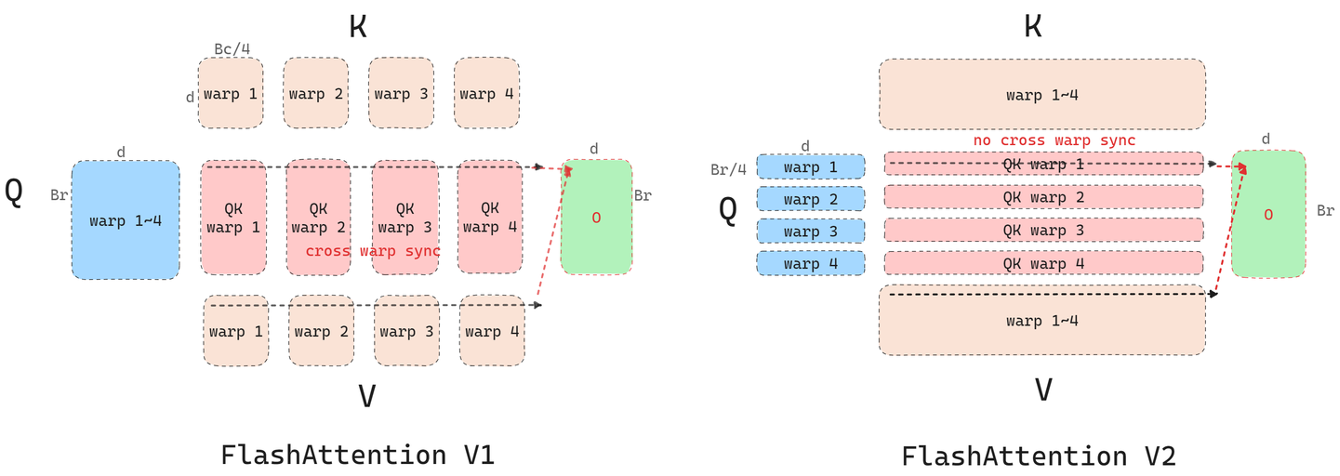

改进三:Warp Level 并行度

假设一个 block 实际上会被 SM 划分成 4 个 warp,在 V1 版本中,矩阵 𝐾,𝑉 的 block 会被划分成 4 个 warp,每个 warp 计算

改进三:Warp Level 并行度(cont'd)

在 V2 版本中,矩阵 𝑄 的 block 会被划分成 4 个 warp,这种情况下每个 warp 计算出来的结果就是一个

FlashAttention

- Installation

- GPU Basics

- FlashAttention V1

- FlashAttention V2

- Other

FlashAttention 使用途径

- 使用官方库 flash_attn,可以通过 pip 直接安装,这种方法如果需要做一些逻辑上的修改(例如加 mask),学习和 Debug 的成本较高

- 使用 Triton Language 中的实现,实际性能也很好

- LeetCUDA: https://github.com/xlite-dev/LeetCUDA