MoE中的稀疏

不“怎么”增加模型计算开销的情况下,提升模型的体积

模型总参数量不变的情况下,降低每次推理的计算开销(所用参数)

MoE结构示例

-

一种"weighted multiplication"

- 其中

- 其中

-

-

为了体现稀疏性,一般选Top-k Gating

- 通常

- 通常

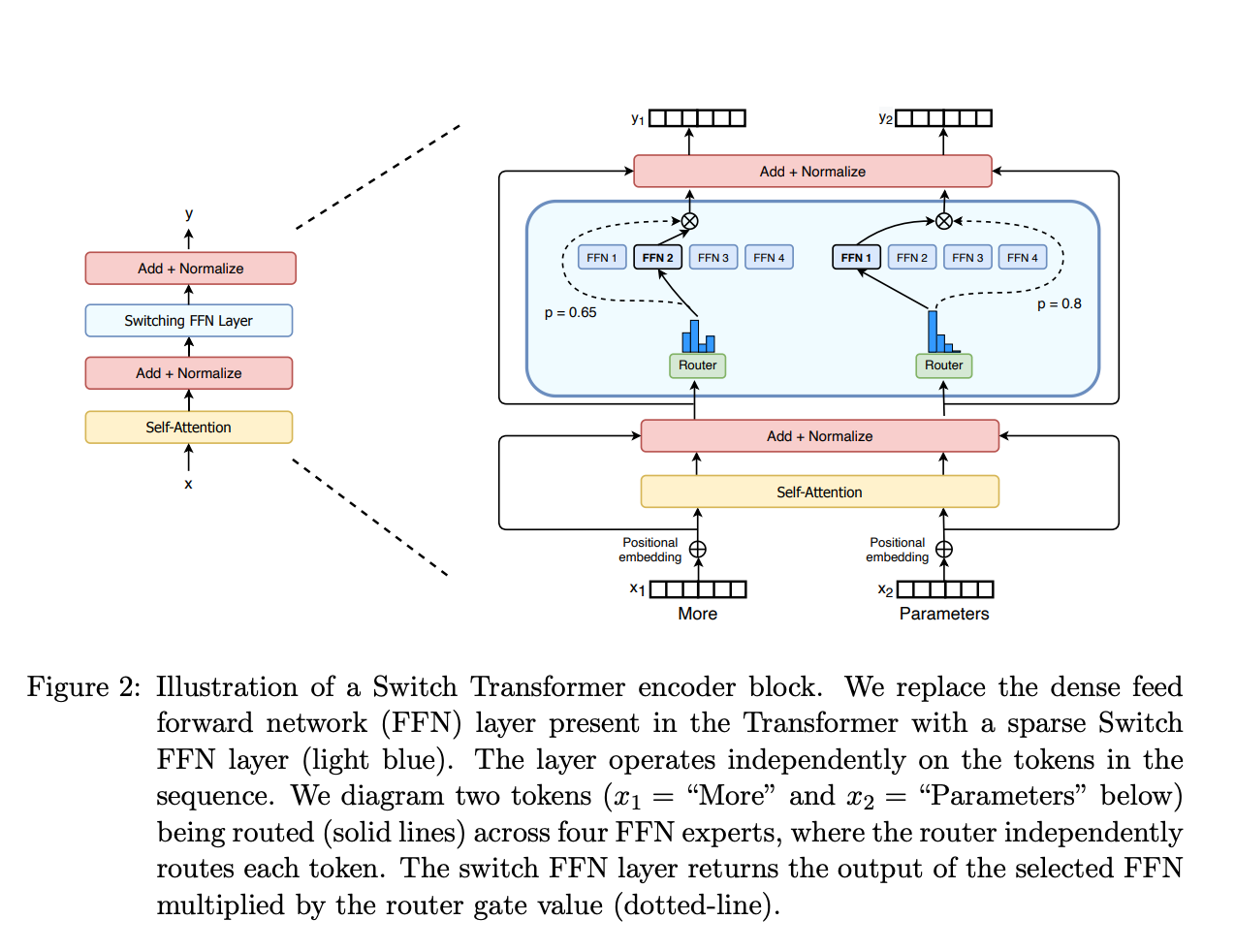

MoE与Transformers

Switch Transformers将Transformers中的FFN替换为MoE结构

MoE与Transformers

- Switch Transformers

- T5-based MoEs going from 8 to 2048 experts

- Mixtral 8x7B

- 8 experts(每次激活2个)

主流MoE模型的experts数量

| 模型 | #Experts | top-k数量 | 备注 |

|---|---|---|---|

| Mixtral 8x22B | 8 | 2 | 专家更大,推理仍保持稀疏 |

| DeepSeek-V3 (670B A37B) | 256+1 | 8+1 | 开源中文 MoE,提供高效推理规模 |

| Qwen3-235B-A22B | 128 | 8 | 阿里开源 |

如何确定MoE中的expert

- 通过训练过程学习参数,确定每个expert

- 以Mixtral 8x7B为例

- 将FFN layer扩展为8个expert

- 每个expert为原有尺寸的一个FFN layer

- 通过Gating network选择最适合的expert

- 将FFN layer扩展为8个expert

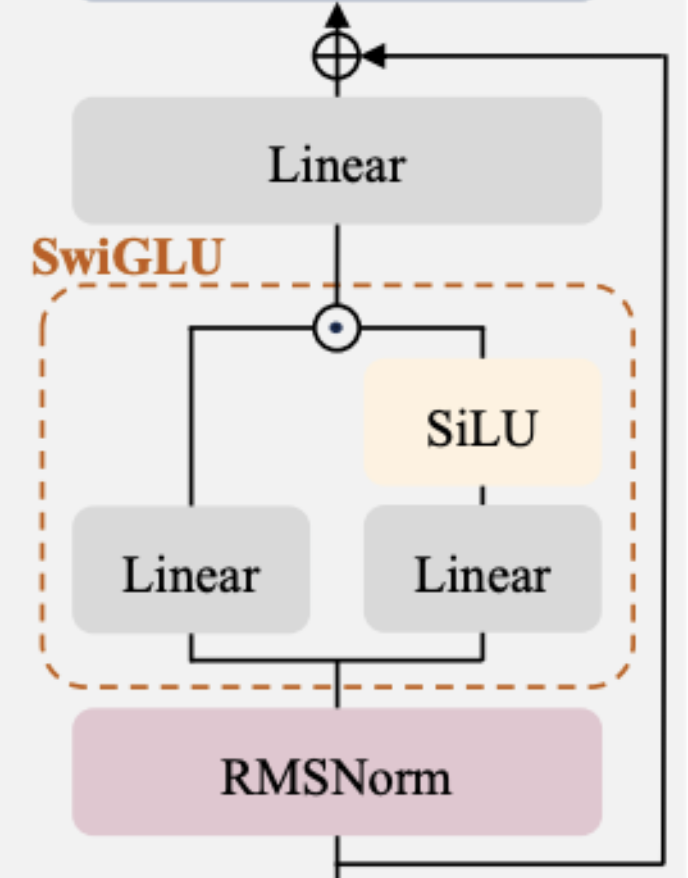

前馈神经网络(FFN)

标准FFN实现

(mlp): LlamaMLP(

(gate_proj): Linear(in_features=2048, out_features=8192, bias=False)

(up_proj): Linear(in_features=2048, out_features=8192, bias=False)

(down_proj): Linear(in_features=8192, out_features=2048, bias=False)

(act_fn): SiLU()

)

- 默认包含Gate projection:

- self.down_proj(self.act_fn(self.gate_proj(x)) * self.up_proj(x)

MoE代码示例:Gating Network

import torch

import torch.nn as nn

class TopKGating(nn.Module):

def __init__(self, hidden_dim, num_experts, k=2):

super().__init__()

self.router = nn.Linear(hidden_dim, num_experts, bias=False)

self.k = k

def forward(self, x):

scores = self.router(x) # [batch, experts]

topk_scores, topk_idx = torch.topk(scores, self.k, dim=-1)

probs = torch.softmax(topk_scores, dim=-1)

gate = torch.zeros_like(scores)

gate.scatter_(-1, topk_idx, probs)

return gate, topk_idx

router根据输入生成专家打分,通过topk仅保留稀疏激活gate中的概率用于加权专家输出,topk_idx决定调用哪些expert

MoE的训练

- 通过load balancing训练MoE

- MoE训练之前:初始化每个expert,且并无任何含义

- 不加任何控制的训练:每次选取top-k(=2)的expert进行训练和参数更新,容易使模型选择被训练的快的experts

- load balancing: 在训练过程中,赋予每个expert近乎相同数量的训练样本

- DeepSeek-V3 通过共享专家与容量约束(capacity factor)等机制控制路由均衡,因此并未额外引入Switch Transformer式的auxiliary loss

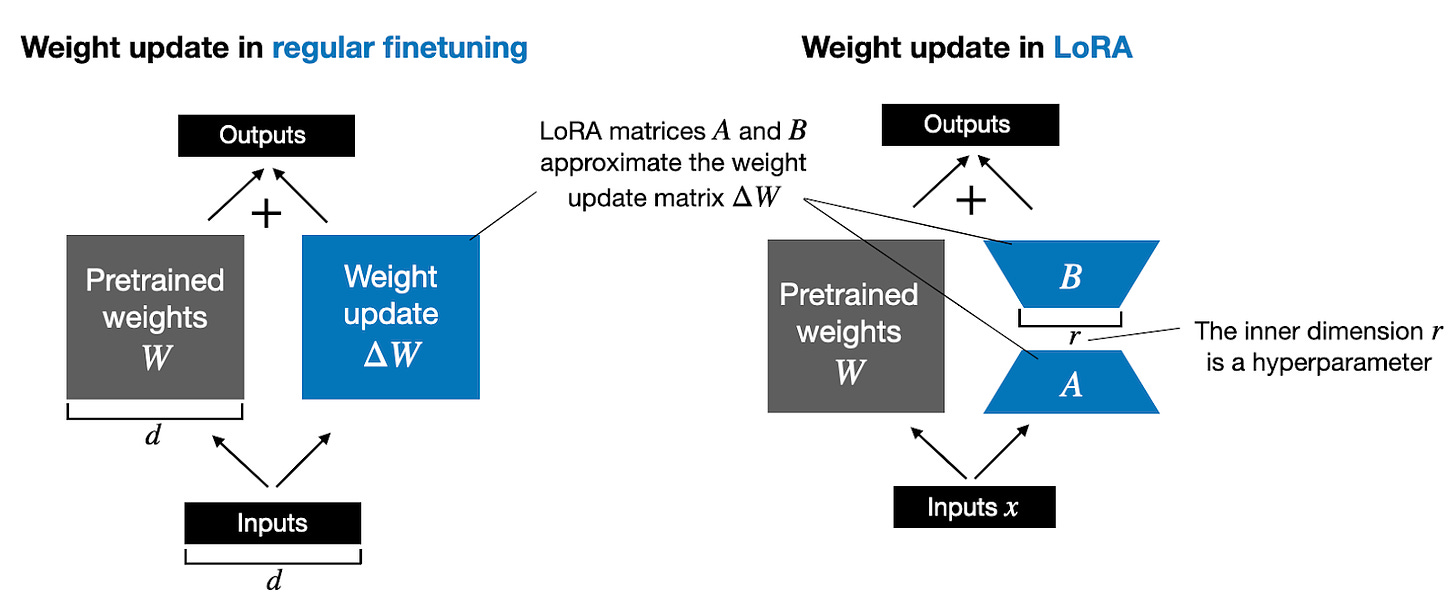

Low-rank adaptation (LoRA)

- 一种流行的轻量级LLM微调技术

- 通过很少的trainable parameters,快速微调LLM

LoRA基本思路

- 传统的training和finetuning

- LoRA

LoRA推理

- 传统的training和finetuning后的推理过程

- LoRA推理

LoRA实现

import torch.nn as nn

class LoRALayer(nn.Module):

def __init__(self, in_dim, out_dim, rank, alpha):

super().__init__()

std_dev = 1 / torch.sqrt(torch.tensor(rank).float())

self.A = nn.Parameter(torch.randn(in_dim, rank) * std_dev)

self.B = nn.Parameter(torch.zeros(rank, out_dim))

self.alpha = alpha

def forward(self, x):

x = self.alpha * (x @ self.A @ self.B)

return x

LoRA实现

class LinearWithLoRA(nn.Module):

def __init__(self, linear, rank, alpha):

super().__init__()

self.linear = linear

self.lora = LoRALayer(

linear.in_features, linear.out_features, rank, alpha

)

def forward(self, x):

return self.linear(x) + self.lora(x)

浮点数表示

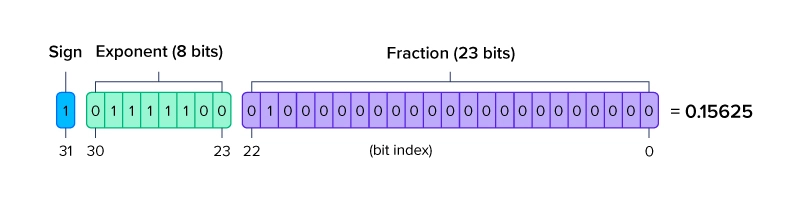

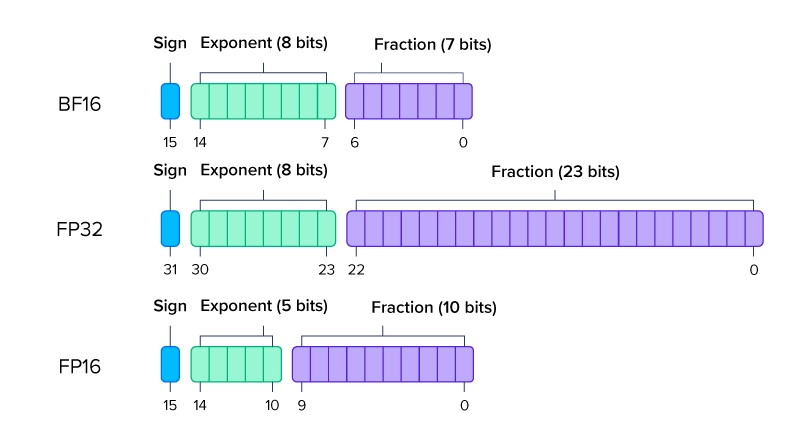

- 浮点数,又称floating point,是一种有符号的二进制数,考虑其精度(Precision),通常有:

- 双精度: FP64

- 单精度: FP32

- 半精度: FP16

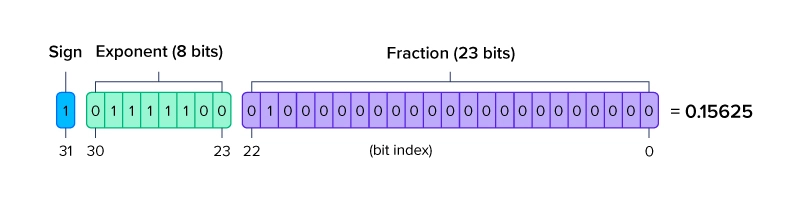

浮点数表示

- 以FP32为例:

- 符号位: 1位 sign

- exponent部分: 8位 exponent

- fraction部分: 23位 fraction

浮点数表示

浮点数表示

浮点格式对比

| 格式 | 尾数 | 指数 | 近似数值范围 | 常见场景 |

|---|---|---|---|---|

| FP32 | 23 | 8 | 1.18e-38 ~ 3.4e38 | 全精度训练、关键评估 |

| BF16 | 7 | 8 | 1.18e-38 ~ 3.4e38 | 大规模训练,保留 FP32 动态范围 |

| FP16 | 10 | 5 | 6.10e-5 ~ 6.55e4 | 混合精度训练、推理 |

| FP8 (E4M3 / E5M2) | 3 / 2 | 4 / 5 | 2.4e-2 ~ 4.48e2 / 5.96e-4 ~ 5.73e4 | 最新 GPU 上的高效推理/训练 |

精度与量化衔接

- 动态范围越大,越能容忍梯度与激活的波动(如 BF16 对比 FP16)

- 尾数位数越多,保留的有效精度越高(FP16 在小数部分优于 BF16)

- 常见流程:混合精度训练(BF16/FP32)→ 推理阶段量化(INT8/INT4)

- INT8:服务器推理主流选择,兼顾吞吐与精度

- INT4:边缘/移动部署,需配合蒸馏或量化感知训练

- 组合策略:依据模型规模、硬件指令支持与误差容忍度,混用浮点与整型格式

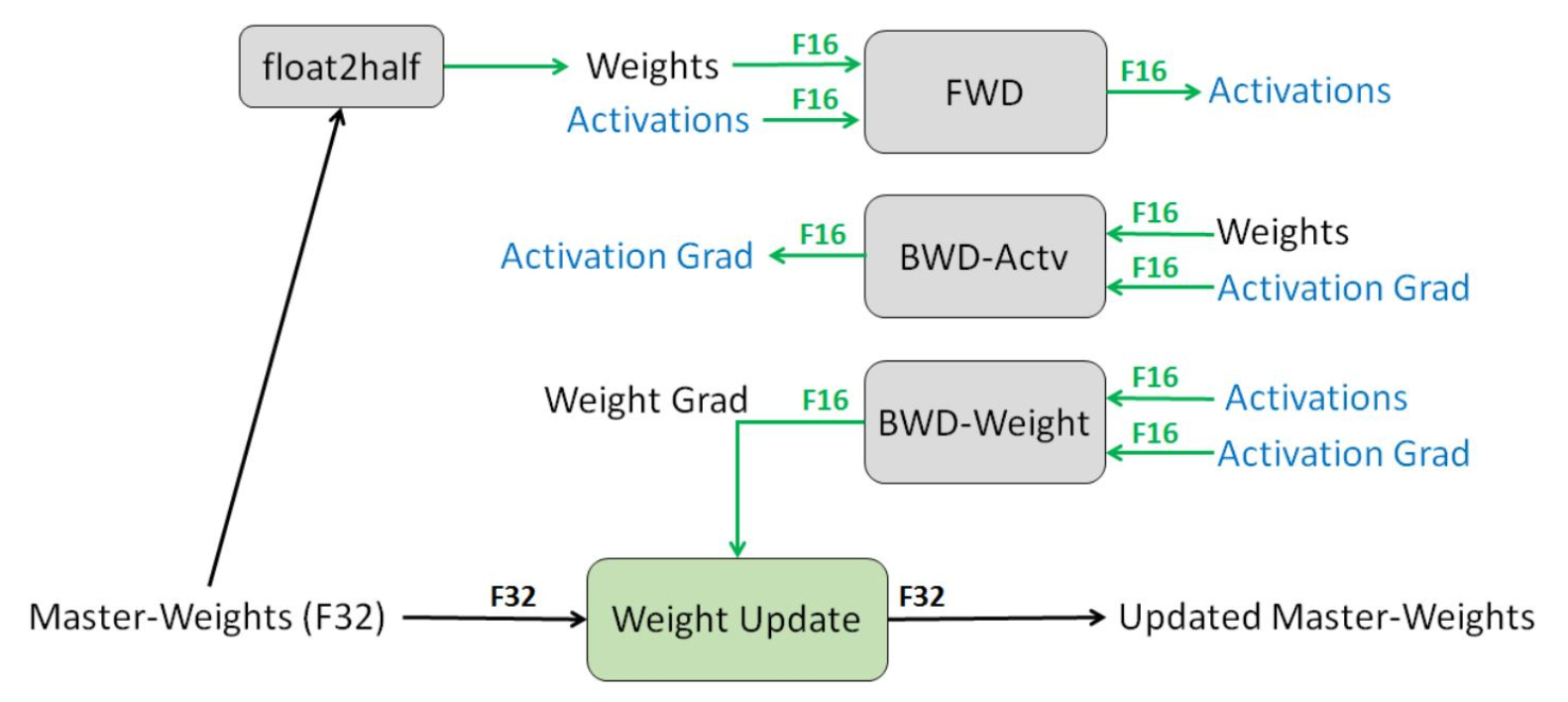

混合精度示意

量化的核心思路

- 把浮点权重与激活压缩到较小的整数范围(如 INT8/INT4),降低显存与带宽占用

- 常见做法:为张量或通道学习缩放因子

scale和零点zero_point- 映射公式:

x_q = round(x/scale + zero_point) - x_q: 量化后数值

- scale: 缩放因子,fp32

- zero_point:零点,表示在浮点数域中值为 0 时,对应的 int8 整数值。

- 映射公式:

量化示意