什么是自然语言处理?

- 自然语言

- 人类使用的语言,如汉语、英语、西班牙语、代码等 -> 文本符号

- 自然语言处理的定义

- “自然语言处理(NLP)是语言学、计算机科学和人工智能的跨学科子领域,关注计算机和人类语言之间的交互,特别是如何编程使计算机能够处理和分析大量的自然语言数据。其目标是使计算机能够“理解”文档的内容,包括其中的语言背景细微差别。然后,这项技术可以准确提取文档中包含的信息和见解,以及对文档本身进行分类和组织。” From WikiPedia, ChatGPT翻译

- 自然语言理解,自然语言生成

自然语言处理任务

- 请填空: 今天我来到了___

- 今天的天气____

- 自然语言处理的任务本质上是一个“填词游戏”

- 目标:如何填的准、说得好

- 手段:条件概率

- 填的准≠人类知道机器按照人类理解世界的方式理解世界

语言模型

基本法: 链式法则

句子由任意长度的字符串组成

- 句子a = 今天我来到了仙II-212。

- 句子b = 今天仙II-212我来到了。

- 用概率衡量句子的“好”:

*自然语言处理(NLP)模型:估计出的(相对准确的)概率分布

语言模型

基本法: 链式法则

- 理想: 直接估计出的(相对准确的)句子概率分布

- 现实: 参考人类小孩学说话,一个字一个字的说

- 怎么学? 链式法则

这就是经典的N-gram model

LLM的前寒武纪时期

- 2017年6月之前

- RNN系列

- 2017年-2022年

- Attention

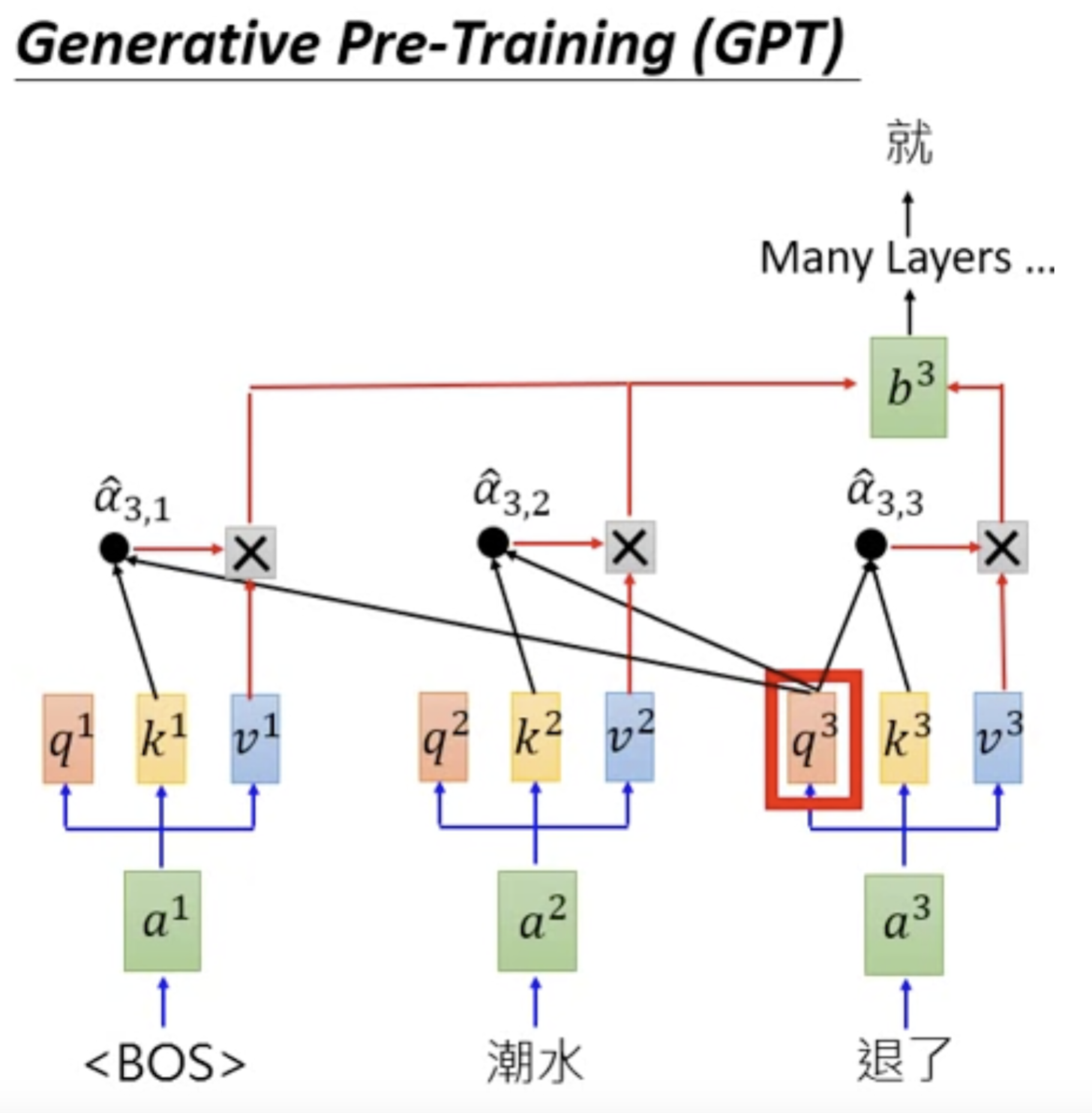

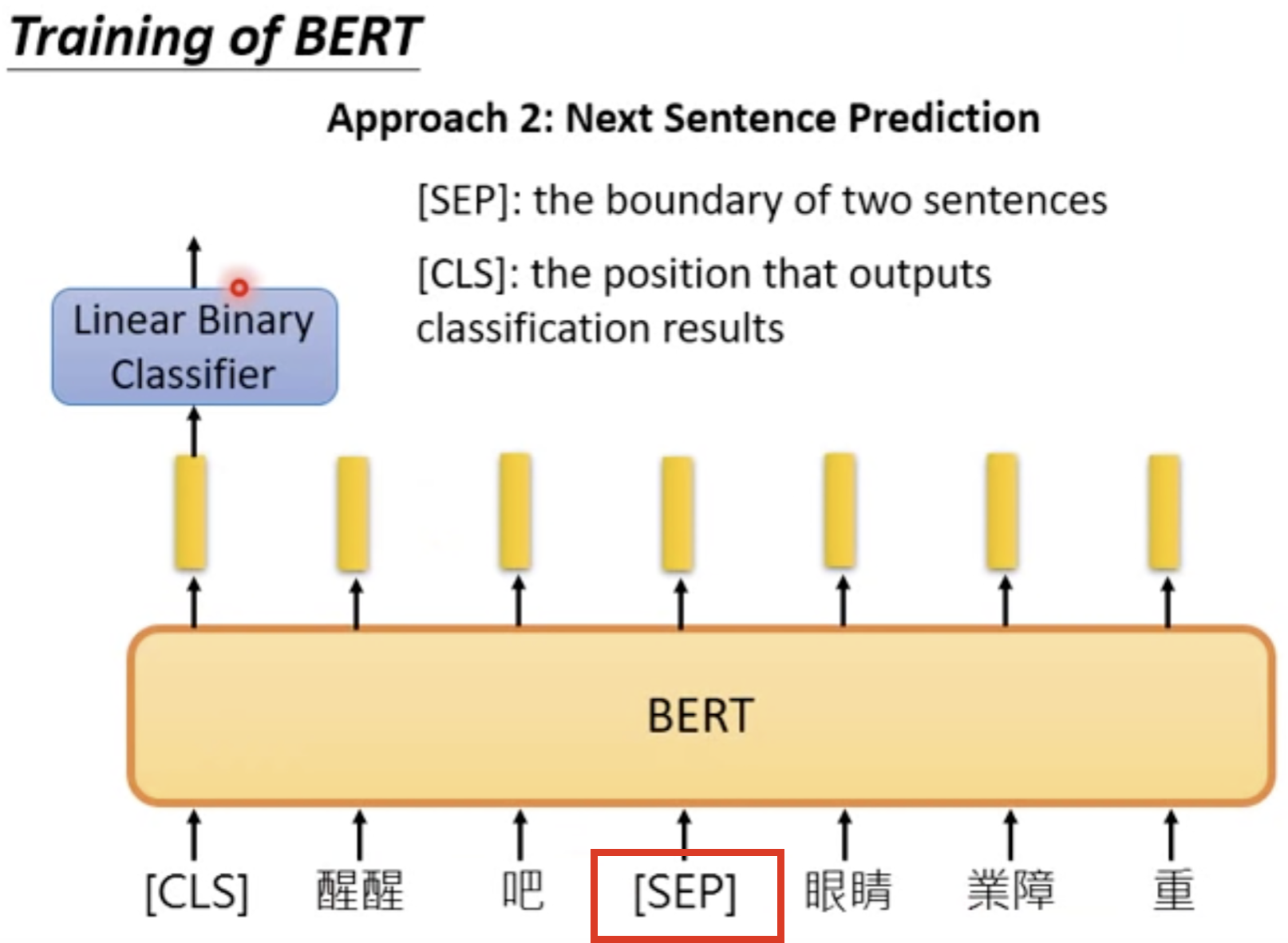

- Transformer界的剑宗气宗之争

- Encoder-decoder派: BERT

- Decoder-only派: GPT系列

Transformer界的剑宗气宗之争

文字接龙(GPT) v.s. 完形填空(BERT)

LLM的寒武纪大爆发

- OpenAI发布ChatGPT

- GPT系列: GPT-3.5, GPT-4, GPT-4 Turbo, GPT4o...

- 其他公司

- 国外: LlaMA家族, Gemini, Mistral, Mixtral, Claude, ...

- 国内: Deepseek, 文心一言, GLM(智谱清言), Moonshot(月之暗面), 通义千问, abab(MiniMax), ...

开发LLM少不了开源社区的支撑

-

深度学习框架: PyTorch

-

模型社区: Huggingface

-

其他: LlaMA-factory, deepspeed, magatron, triton, llama.cpp, llama2.c, llm.c, ...

-

开发语言: Python, CUDA, C++, ...

Talk is cheap. Show me the code.

准备:

- Python 3.8+

- 设备: 最好有N卡,实在没有也没关系,内存大一点

- 虚拟环境: conda

- 环境配置: PyTorch, Transformers, PEFT, triton, ...

- 绝大部分可通过pip或conda安装