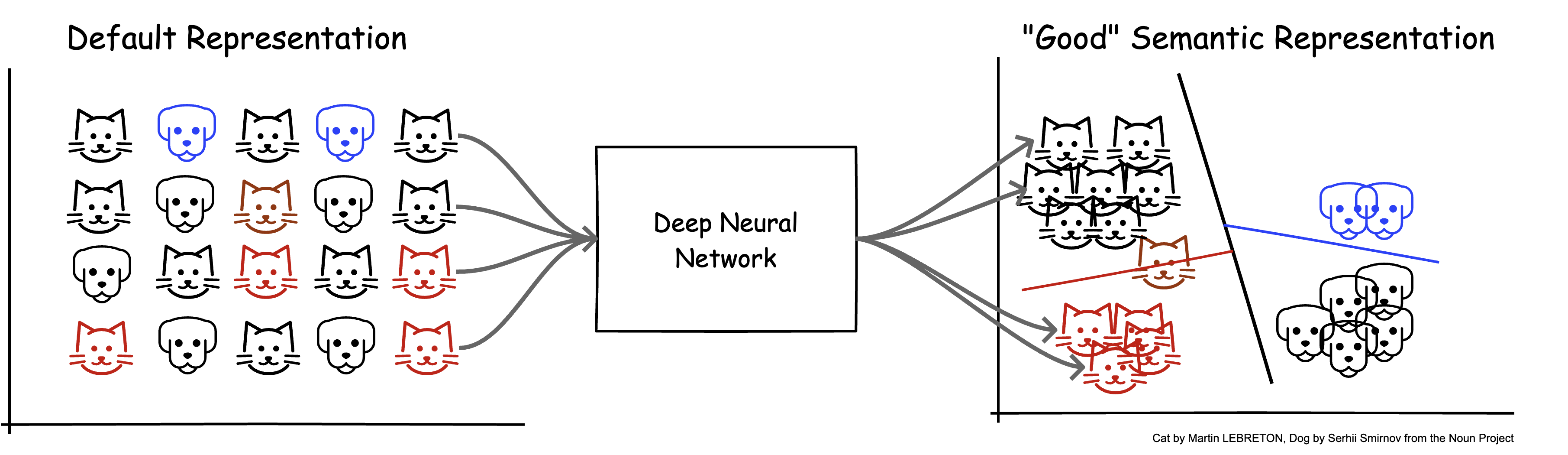

深度学习的特点

- 表示学习(representation learning)

深度学习模型

深度学习模型

结构

- 前n-1层(堆叠)

- 输入: 特征表示

- 输出: 特征表示

- 第n层

- 输入: 特征表示

- 输出: 任务目标

深度学习模型的一层

- 表示空间的变换

PyTorch手搓y=xW^T+b

- 矩阵乘法 (Matrix multiplication)

- @

- torch.matmul, tensor.matmul

- 元素乘法 (element-wise multiplication)

- *

- torch.mul, tensor.mul

编码时间

矩阵乘

y = x@w

y = x.matmul(w)

y = torch.matmul(x, w)

元素乘

y = x*w

y = x.mul(w)

y = torch.mul(x, w)

最基础/核心的"积木"

线性层 (torch.nn.Linear):

-

torch.nn.Linear(in_features, out_features, bias=True, device=None, dtype=None)

- in_features: size of each input sample

- out_features: size of each output sample

-

PyTorch中的输入/输出: 都是tensor

- input:

- output:

- input:

"积木"nn.Linear的要素

self.in_features = in_features

self.out_features = out_features

self.weight = Parameter(torch.empty((out_features, in_features), **factory_kwargs))

- weight: W

- 规约了输入输出的尺寸

"积木"nn.Linear的要素

def forward(self, input: Tensor) -> Tensor:

return F.linear(input, self.weight, self.bias)

- 计算方法forward: 定义输入到输出的计算过程

- nn.Linear的forward: 实现

- nn.Linear的forward: 实现

nn.Linear的使用

Torch docs中的官方示例

m = nn.Linear(20, 30)

input = torch.randn(128, 20)

output = m(input)

print(output.size())

新手村之积木堆叠

m1 = nn.Linear(20, 30)

m2 = nn.Linear(30, 40)

x = torch.randn(128, 20)

y1 = m1(x)

y2 = m2(y1)

- 基于nn.Linear实现以下函数组合

这样的输入行么?

x = torch.randn(128, 4096, 30, 20)

y = m1(x)

y = m2(y)

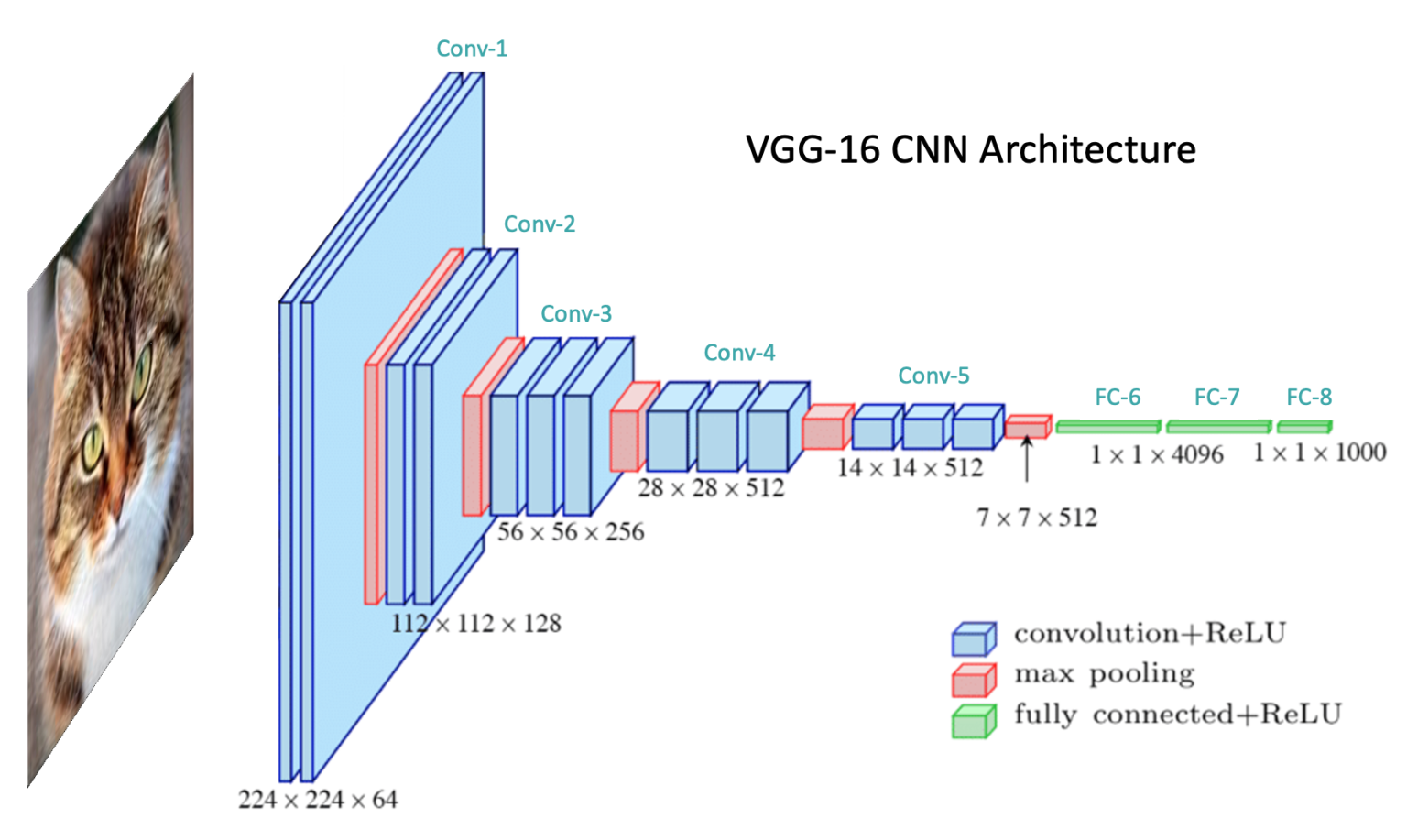

多种多样的积木

- 线性层(Linear layer), 卷积层(Convolutional layer), 池化层(Pooling layer), 各类正则化(XNorm layer)

- 自定义layer

- Attention layer, Decoder Layer, ...

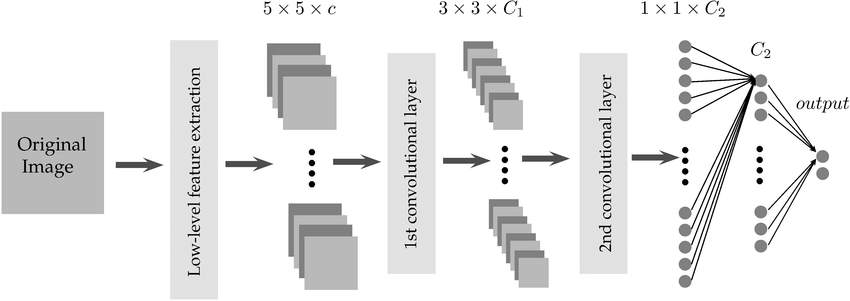

深度学习中的卷积

传统卷积:信号系统中考虑之前时刻的信号经过一些过程后对现在时刻系统输出的影响。

互相关 (cross-correlation):深度学习领域的“卷积”,考虑两个函数之间基于空间位置的相关性

深度学习卷积计算

互相关函数

曾经的面试问题: 卷积计算输出的数值越大,表示什么含义?

卷积示例

卷积层实现

-

torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True, padding_mode='zeros', device=None, dtype=None)

- input shape:

- output shape:

- input shape:

-

编码时刻

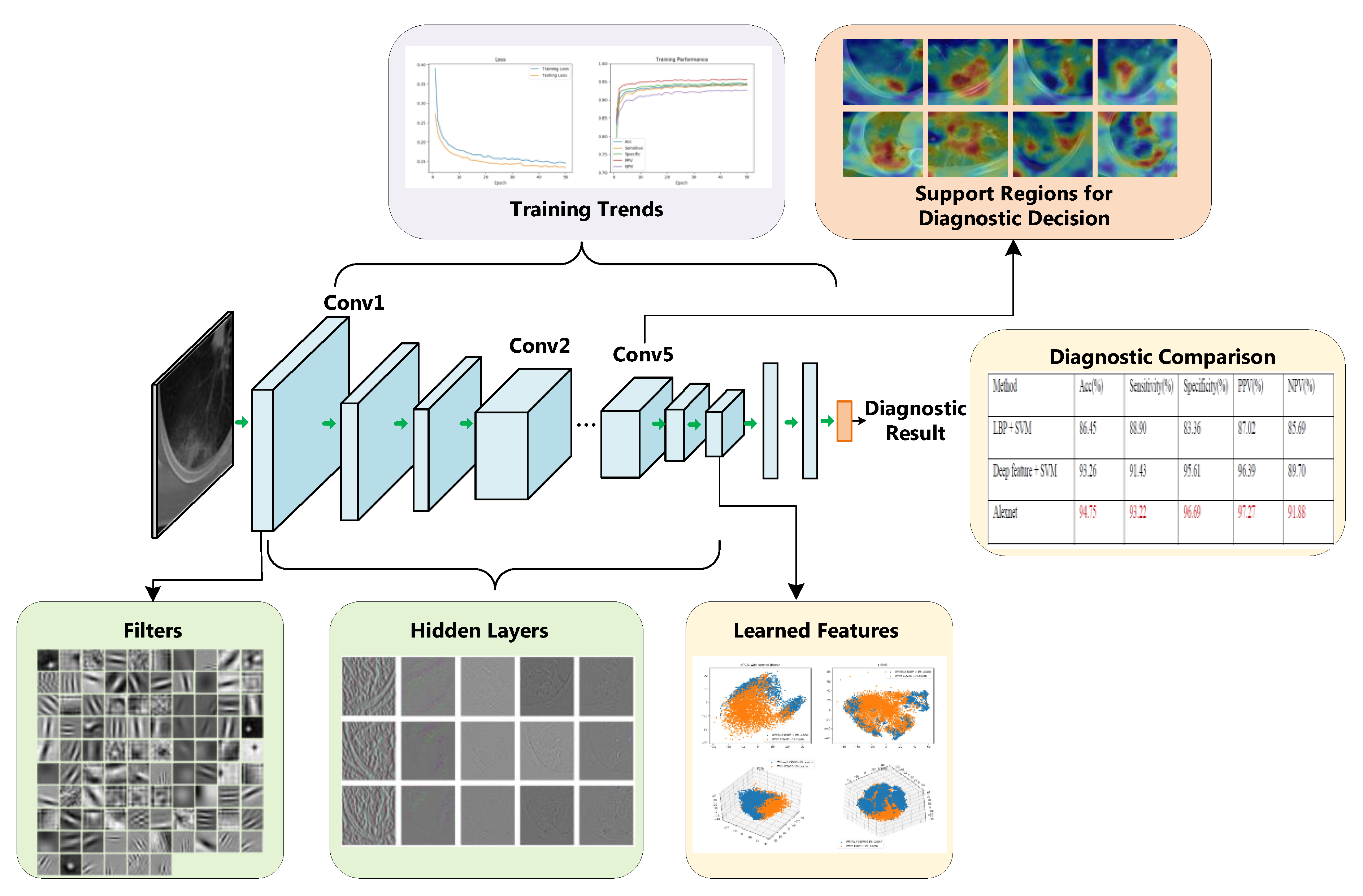

模型训练三要素

- 模型结构(包括模型参数)

- 编码,构建模型

- 静态: 模型结构定义 (init function)

- 动态: 模型推理过程实现 (forward function)

- 编码,构建模型

- 数据集

- Dataset和DataLoader

- 优化器/训练算法

- Loss function,以及优化目标

从积木拼接到构建模型

无比经典的LeNet系列

Channel: 通道/过滤器(卷积核)

从积木拼接到构建模型

从积木拼接到构建模型

数据集

- dataset

- 组织数据集

- 数据集关键要素

- 路径(path), 大小(size), 如何读取单个样本

- dataloader

- 规定数据集的读取方式

优化过程

- 优化器

- 优化目标: Loss function

- 优化算法: 梯度下降(GD)

- 随机梯度下降(SGD), ADAM

- 算法

- train部分

- test部分

Talk is cheap. Show me the code.

使用MNIST/CIFAR-10/fashionMNIST数据集,训练图像分类模型