位置编码与序数编码的关联

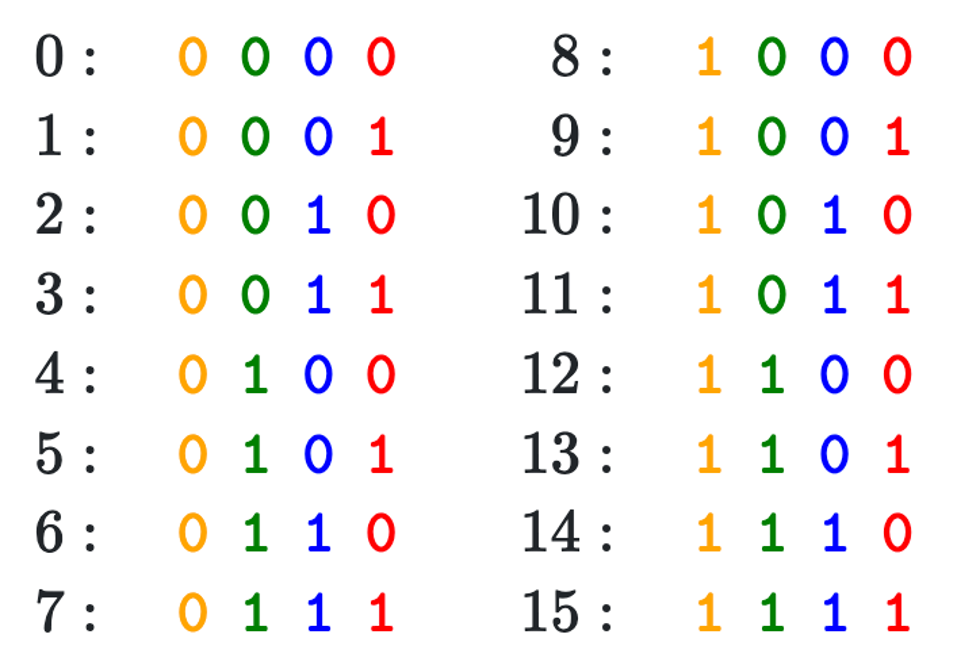

- 序数表示次序,位置编码的用意也在于此。例如从小就学的序数编码:

- 十进制: 1 2 3 4 5 6 7 8 9 10, ...

- 二进制: 0, 1, 10, 11, 100, 101, 110, 111, 1000, 1001, ...

- 但是:

- LLM中的token embedding为向量,如何构造型为向量的位置编码?

序数的周期性

十进制本身是周期性的,二进制也是周期性的

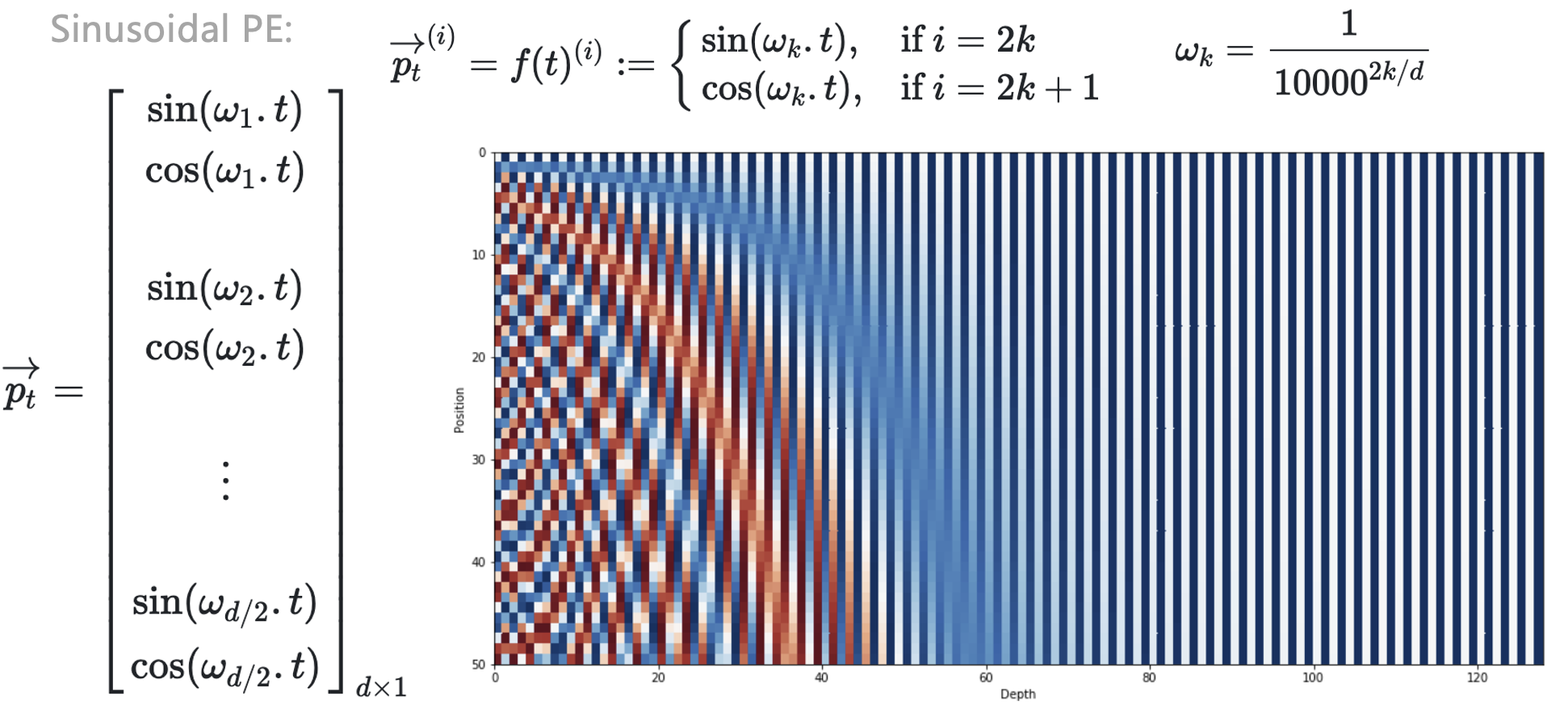

Sinusodial PE

构建n维的位置编码,每一维用不同的周期函数刻画取值

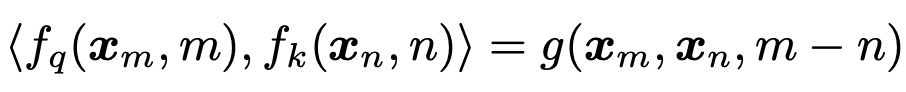

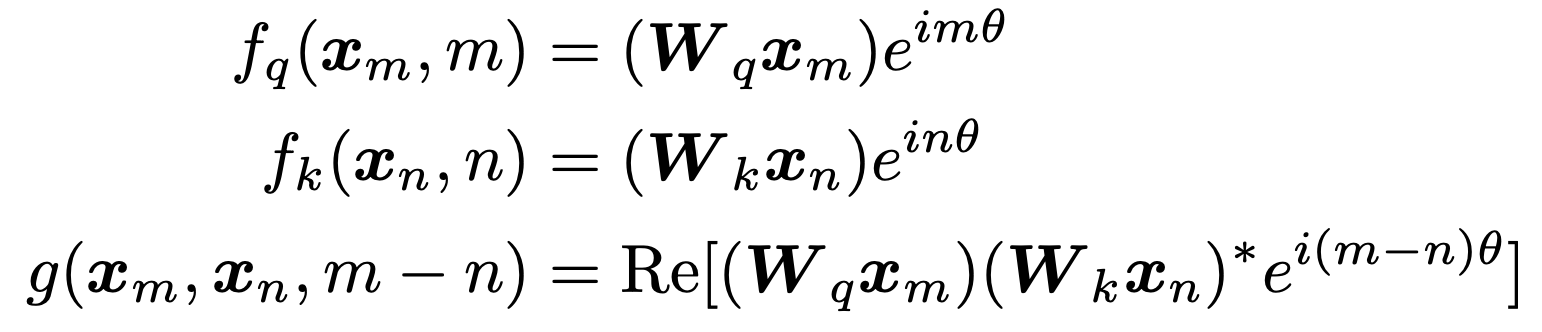

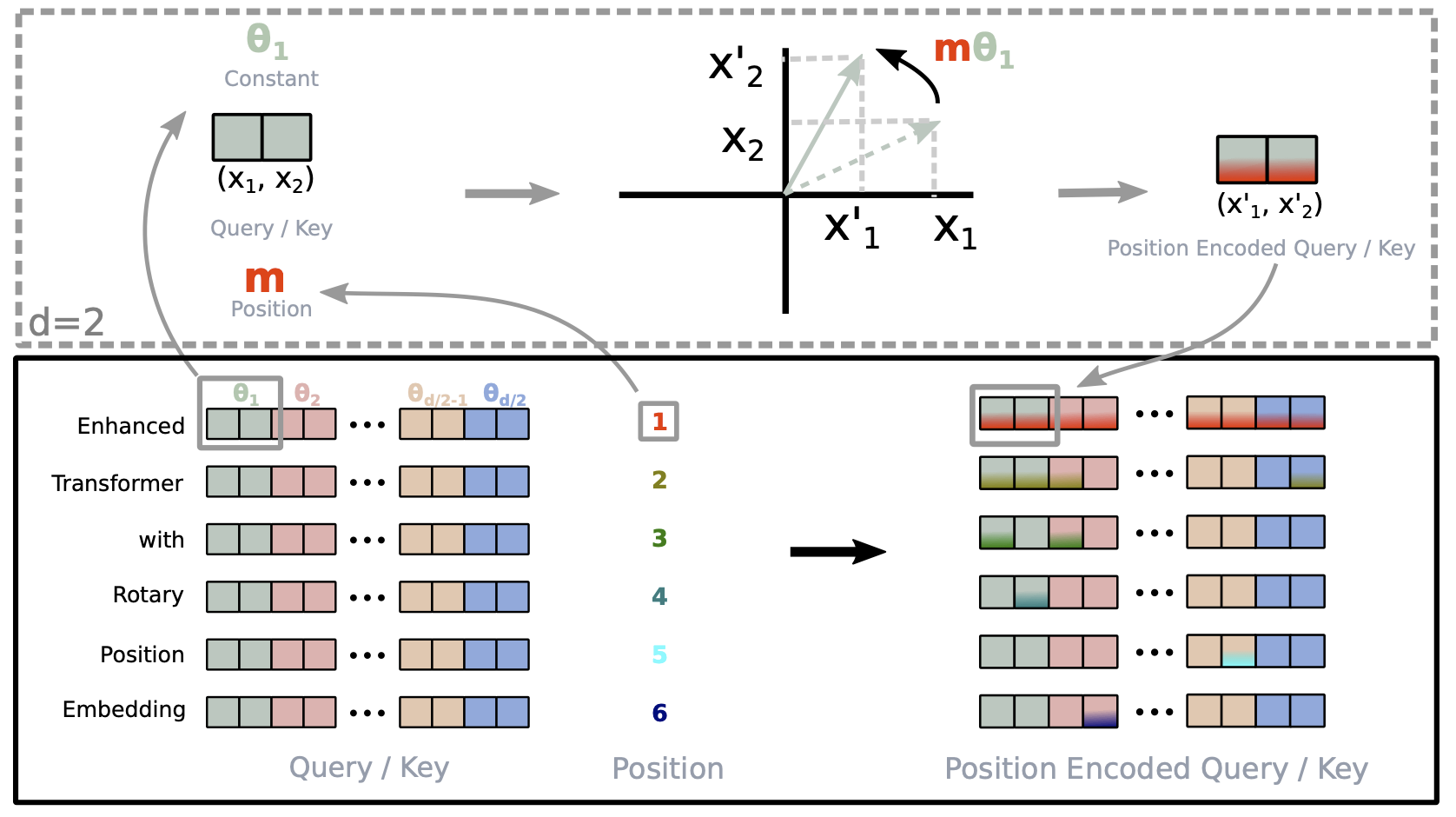

旋转位置编码(Rotary PE)

“叠加旋转位置编码的方式由加法改乘法”

假设两个token的embedding为

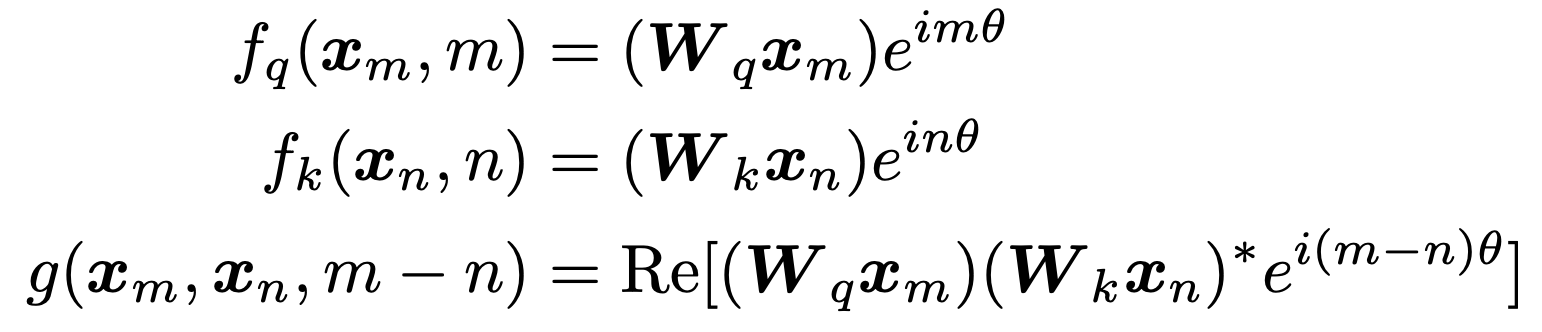

RoFormer提出Rotary PE,在embedding维度为2的情况下:

Rotary PE的2D理解

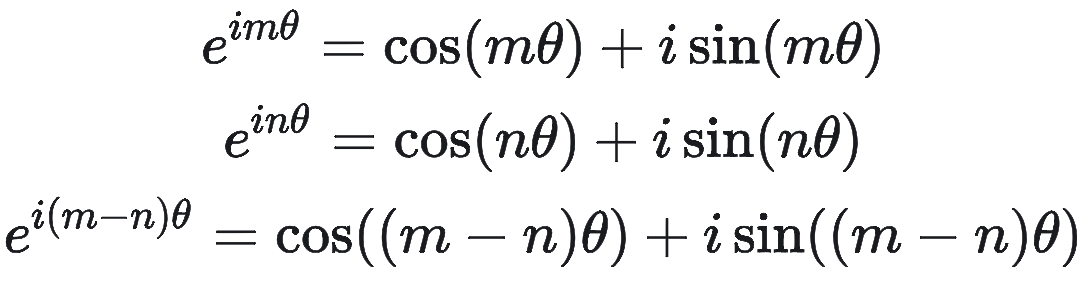

回忆下欧拉公式:

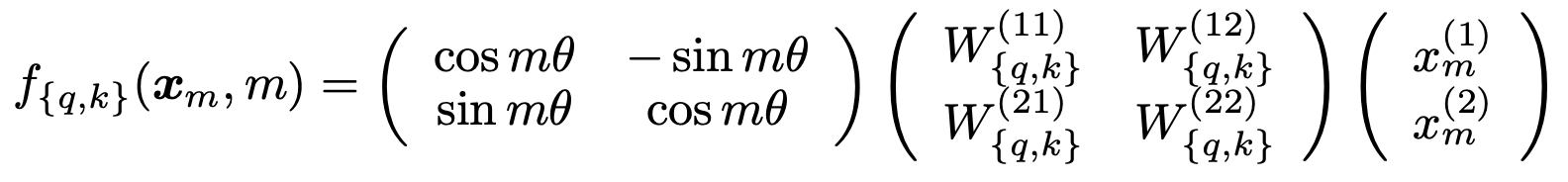

因此,上述函数

RoPE实现

RoPE的2D实现

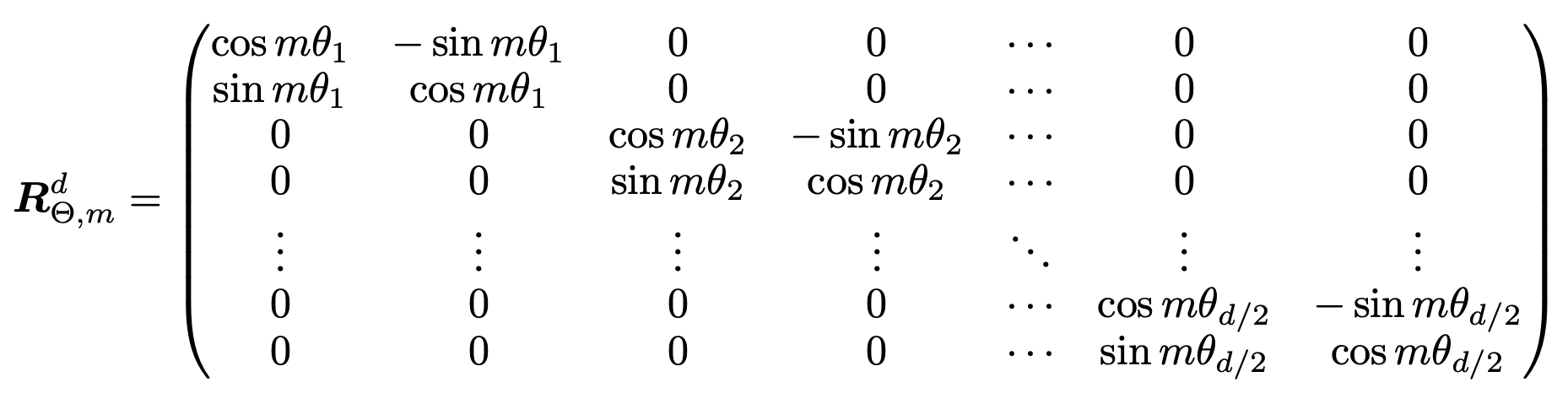

RoPE的n维实现

Rotary PE的可视化展示

RoPE在LlaMA中的构建

不同于经典Transformers结构,只对输入的token做位置编码的叠加

LlaMA中的RoPE在Transformer的每一层都会对Q和K进行位置编码的叠加

拓展阅读&参考文档

Hugging Face

Accelerating a Hugging Face Llama 2 and Llama 3 models with Transformer Engine

RoPE部分

Transformer升级之路:10、RoPE是一种β进制编码. 苏剑林

RoFormer: Enhanced Transformer with Rotary Position Embedding