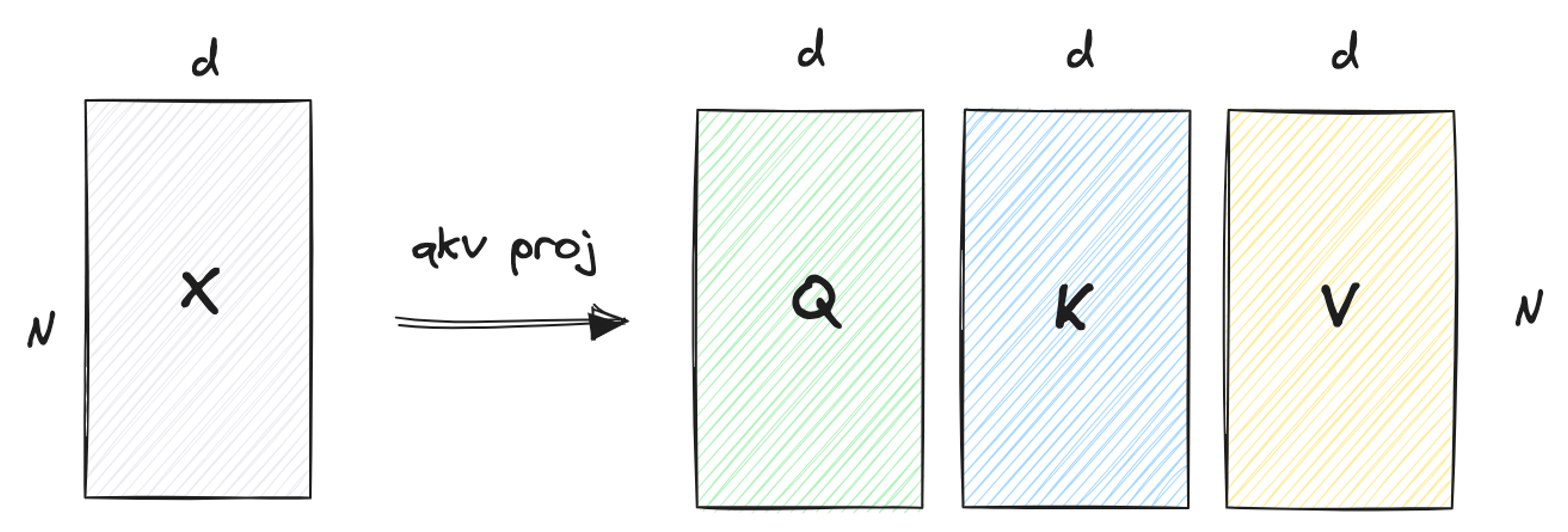

Attention模块的输入

问题:QKV是输入吗?

- 非也,输入是上一层的hidden states

class LlamaAttention(nn.Module):

...

def forward(hidden_states)

...

query_states = self.q_proj(hidden_states)

key_states = self.k_proj(hidden_states)

value_states = self.v_proj(hidden_states)

- 思考:hidden states的shape是怎样的?

标准Attention的第一步: 获得

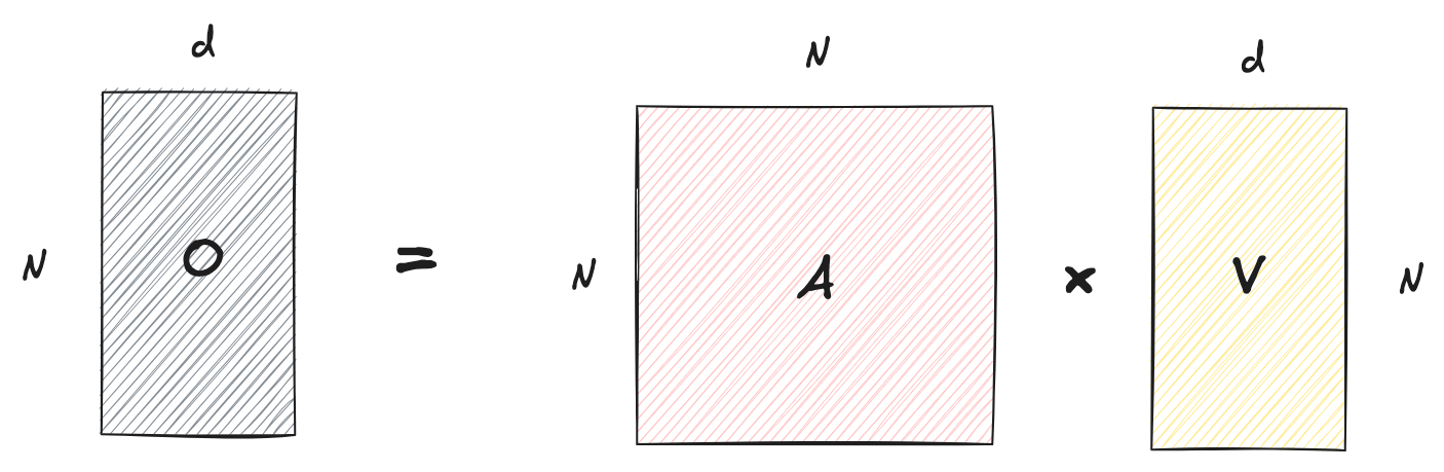

- 给定hidden states(后续简写为

标准Attention的第一步: 获得

- 为方便理解方法,脑补通过tensor.view改变shape

- [batch_size, seq_len, hidden_size] -> [N, d]

- N = batch_size * seq_len, d = hidden_size

- [batch_size, seq_len, hidden_size] -> [N, d]

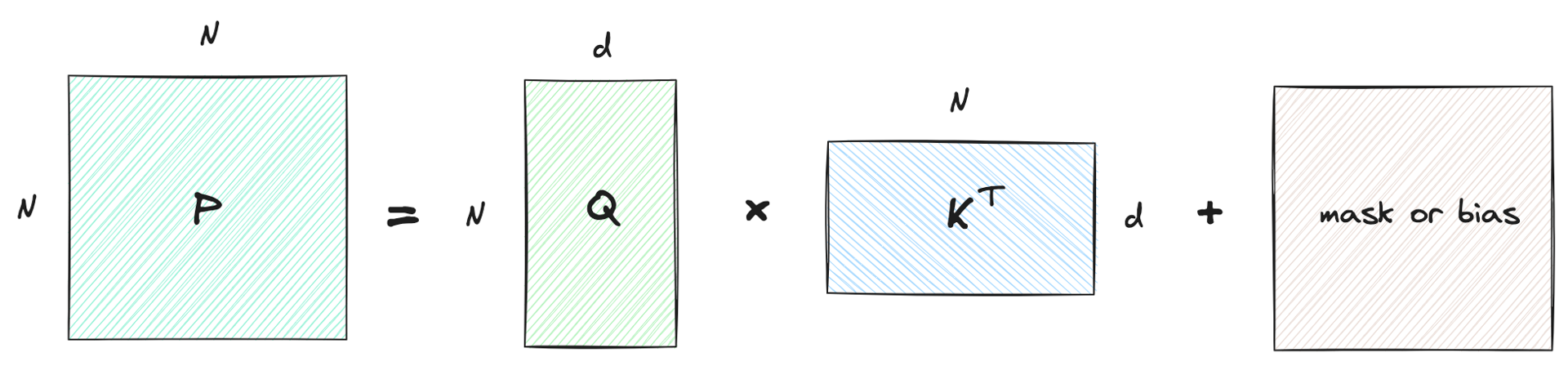

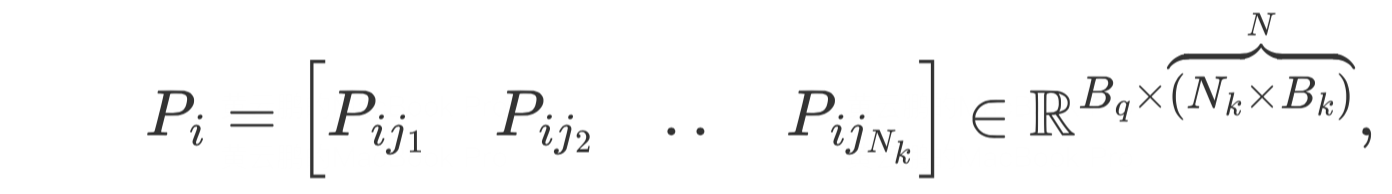

标准Attention的第二步: 计算

-

给定

-

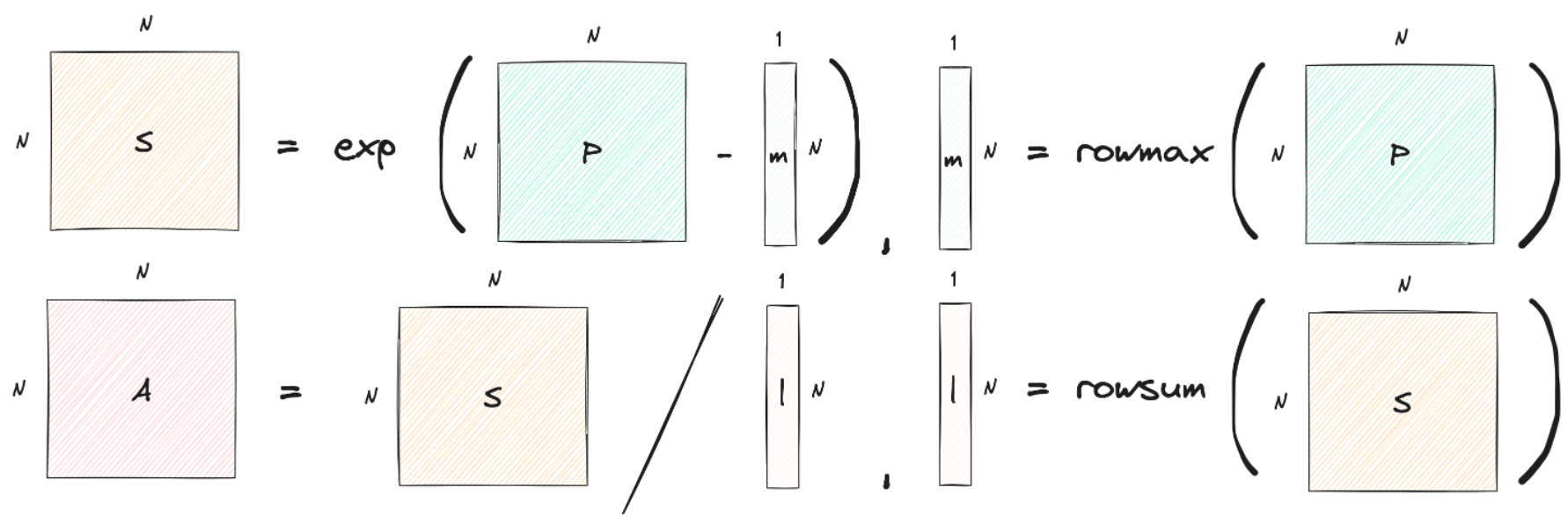

标准Attention的第三步: 计算Attention

- 给定

- row-wise softmax:

- row-wise softmax:

标准Attention的第四步: 计算输出

- 给定

标准Attention回顾

- 给定

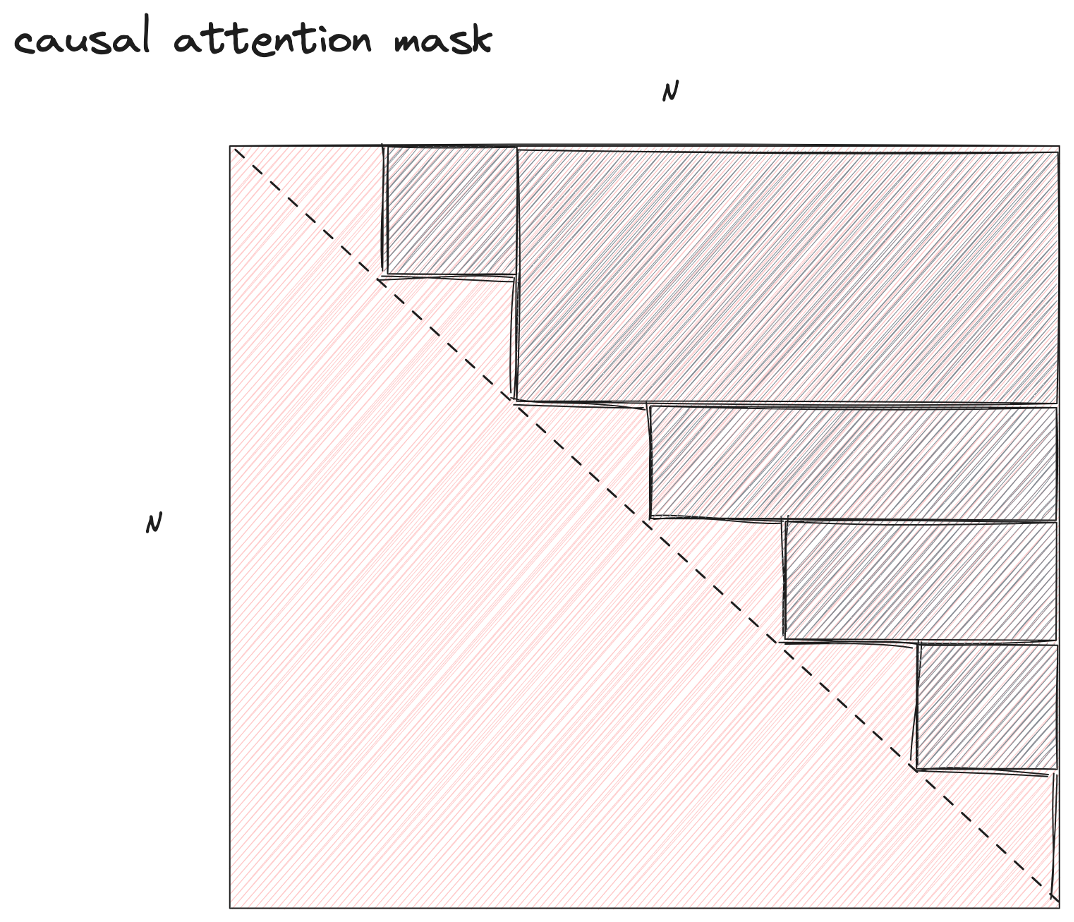

Attention中mask的作用

- 回顾

- <PAD>: 一种表示“padding”的特殊token,用来避免对句子中的某些token的影响

- 为了避免padding对attention的影响,在计算

Attention中mask的作用

对应的实现

移步notebook

MuliHeadAttention

- 标准Attention只生成一个输出A,考虑多种角度,期望得到不同的A

- 靠多个头实现,什么头??

- 拆分

- 些许改造Attention计算过程

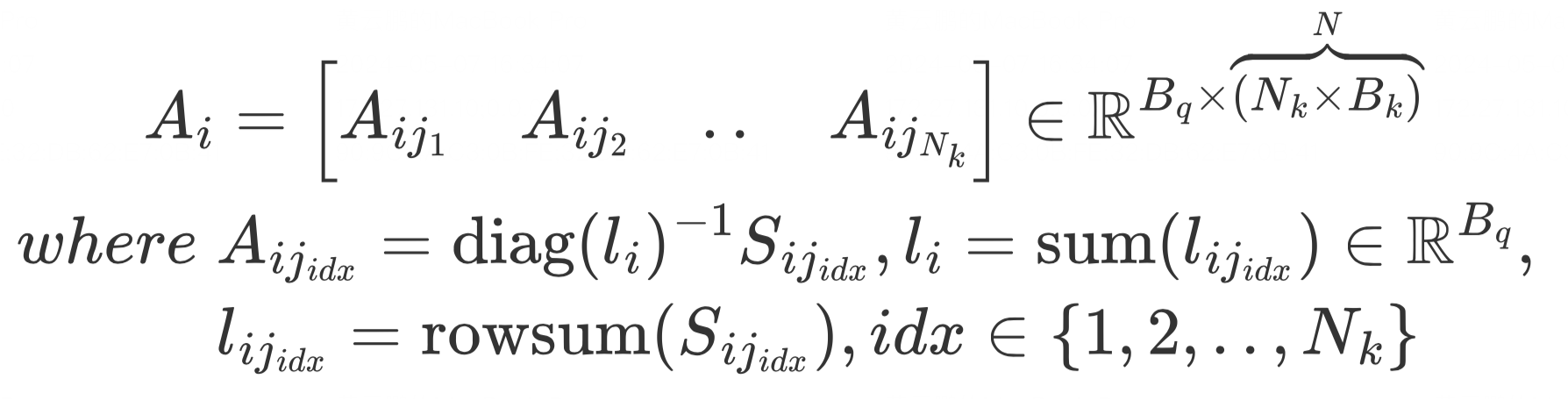

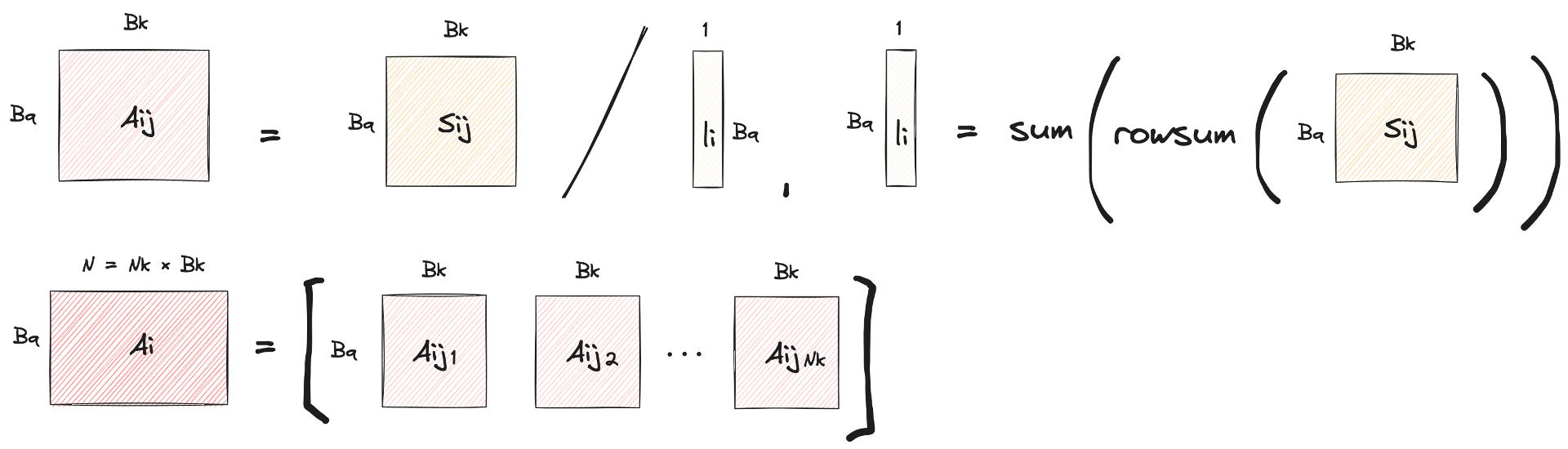

其中,

MultiHeadAttention

- 给定

- 多个heads

- shape的变换(tensor.view实现): [N, d] -> [N, num_heads, head_dim]

- 其中, d = hidden_size = num_heads * head_dim

- 实现中,[bs, seq, hs] -> [bs, seq, nh, hd]

- 再transpose为[bs, nh, seq, hd]

对应的实现

移步notebook

Attention计算开销

- 实际上,可依赖GPU并行执行提升速度

- 分块的并行计算(sm计算单元)

- 如何加速Attention计算?

- BlockedAttention

- FlashAttention

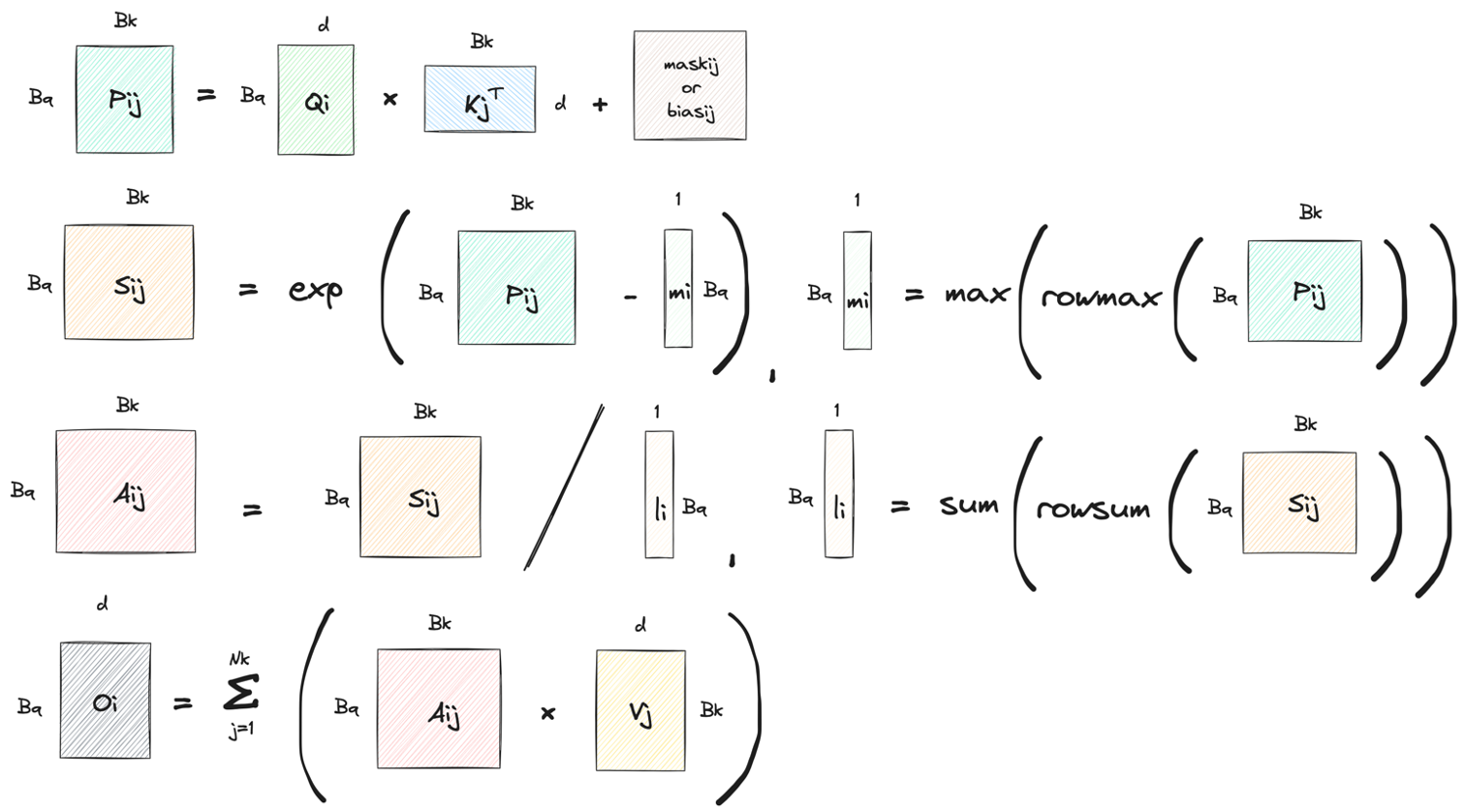

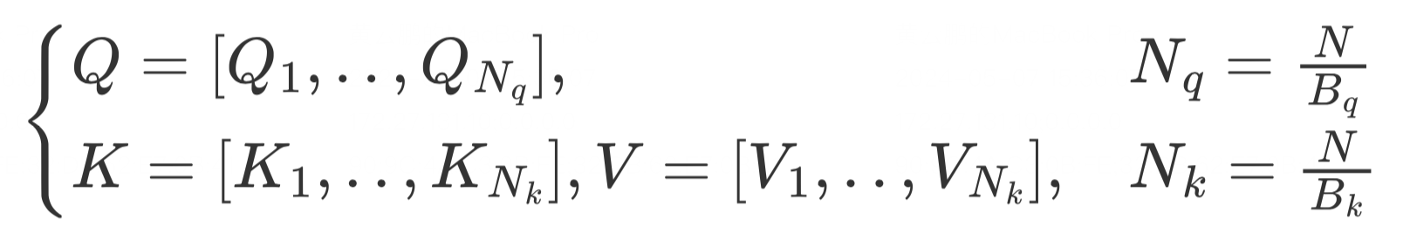

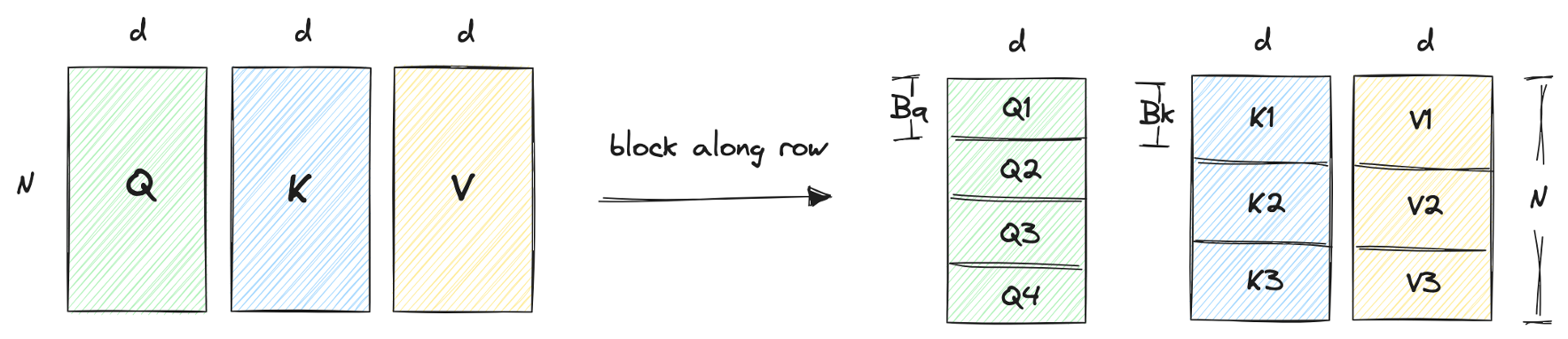

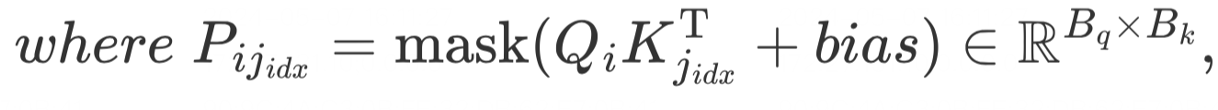

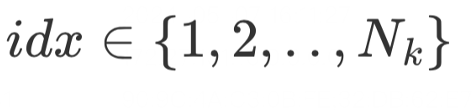

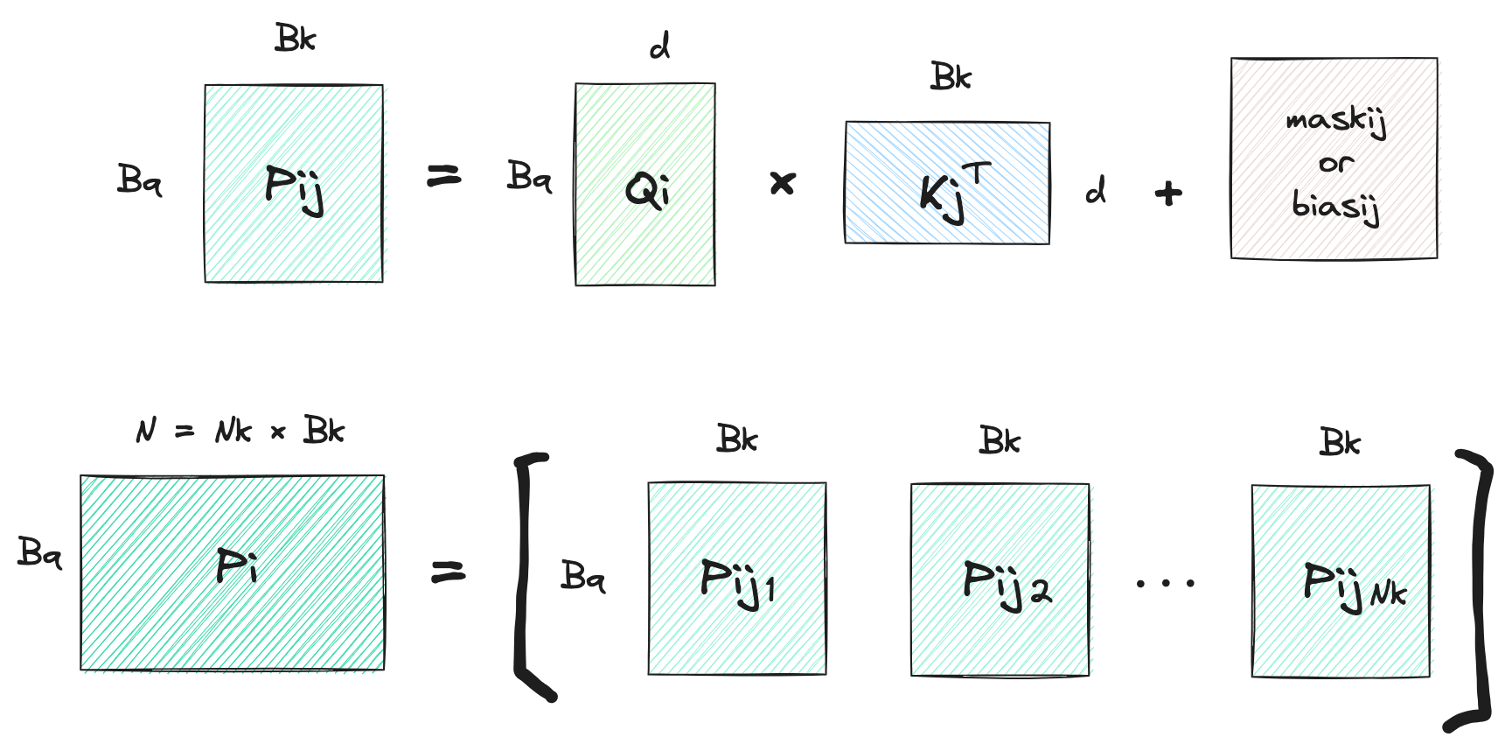

BlockedAttention第一步: 获得

- 给定

BlockedAttention第二步: 计算

- 给定

BlockedAttention第二步: 计算

- 给定

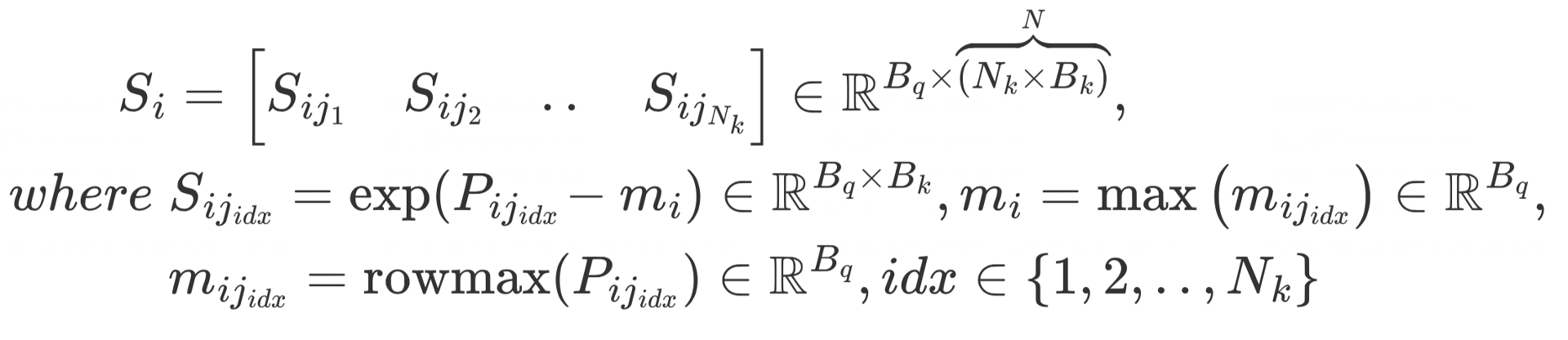

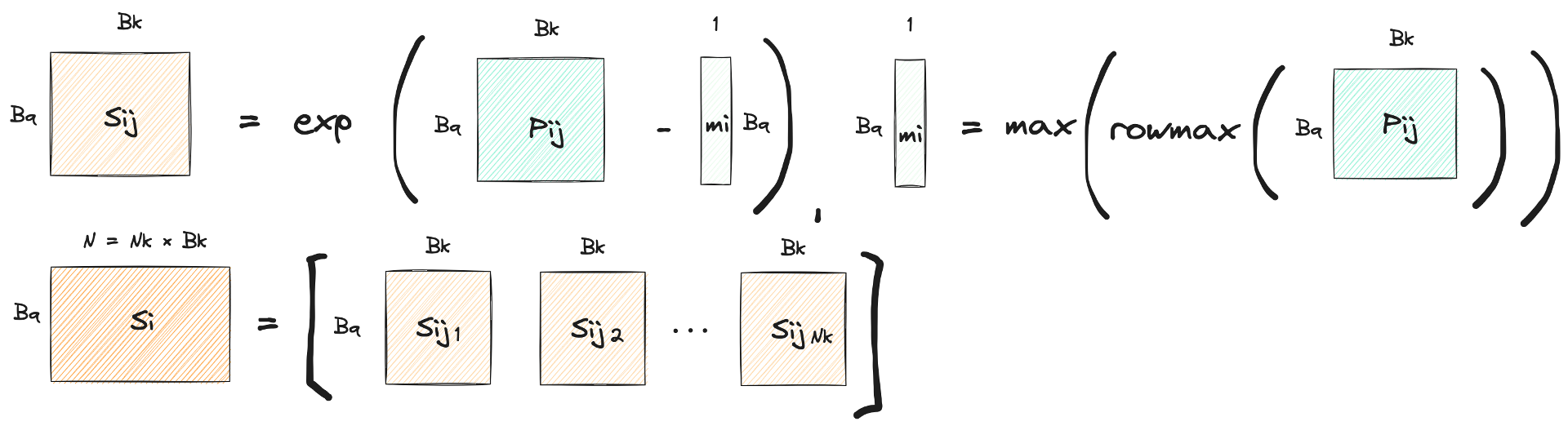

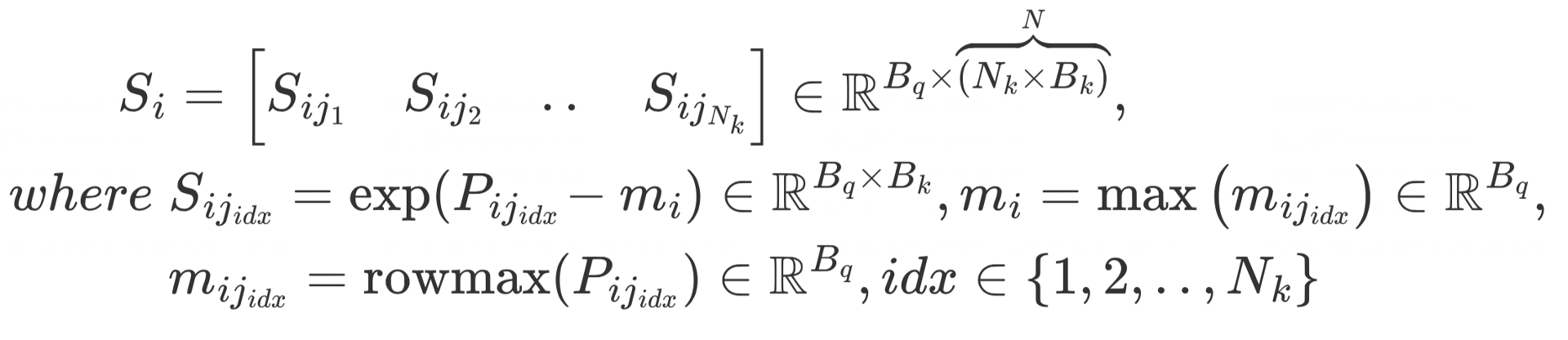

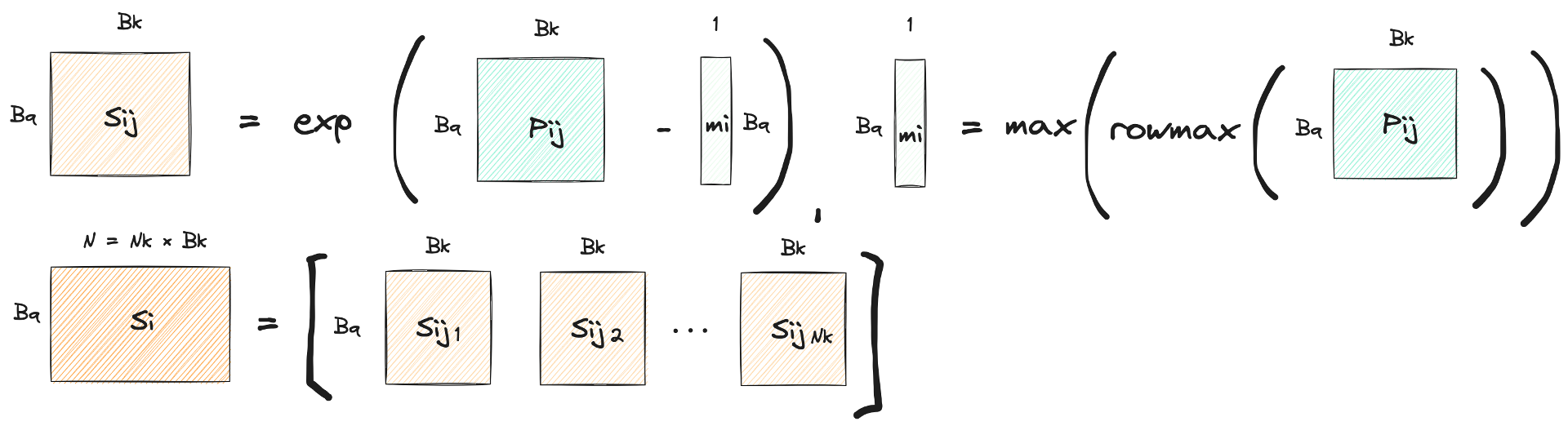

BlockedAttention第三步: 计算Attention

给定

BlockedAttention第三步: 计算Attention

给定

BlockedAttention第三步: 计算Attention

给定

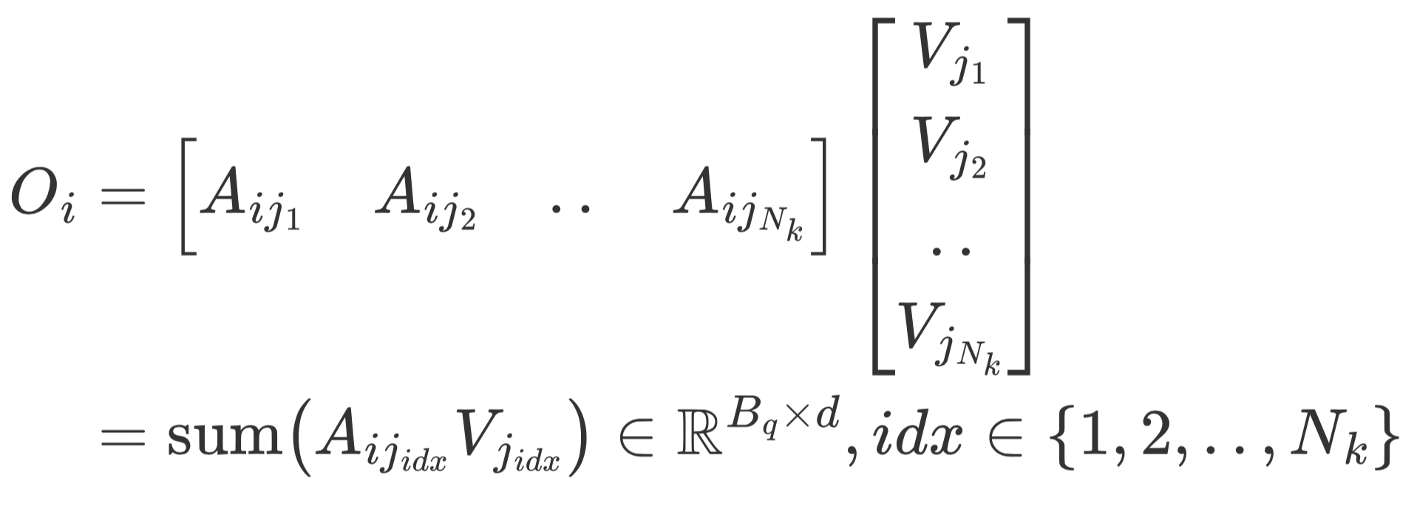

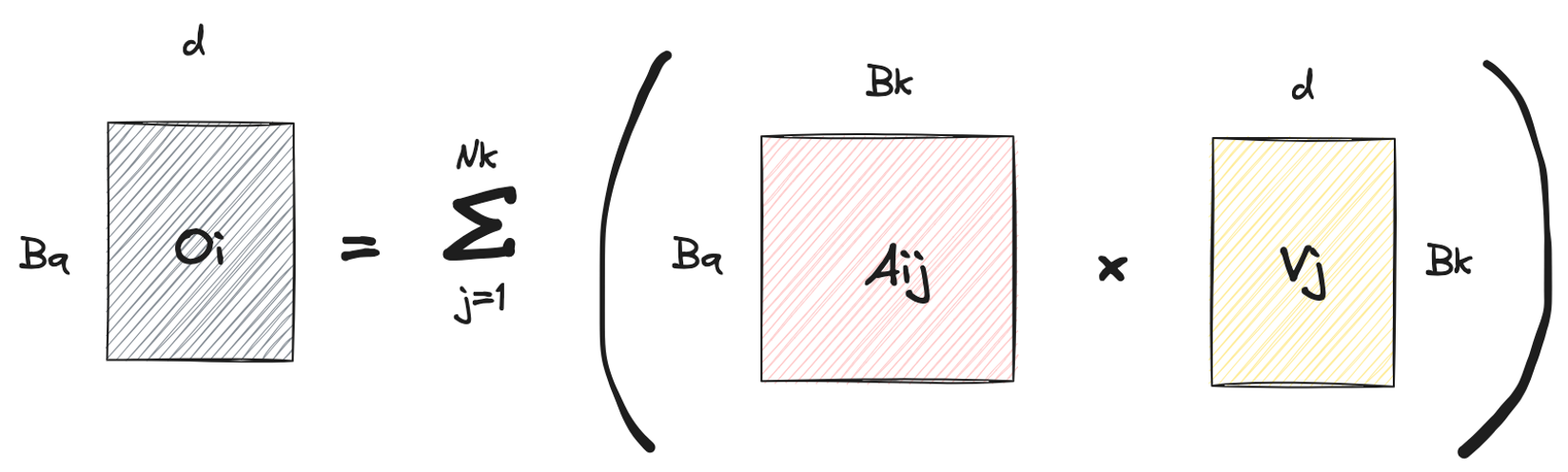

BlockedAttention第四步: 计算

给定

BlockedAttention回顾