优化维度

- 一种思路是:减少每一步中实际访问 HBM(global memory)的次数

- 或者:调整算法步骤,减少整体流程上访问 HBM 的次数

从 block 出发思考问题

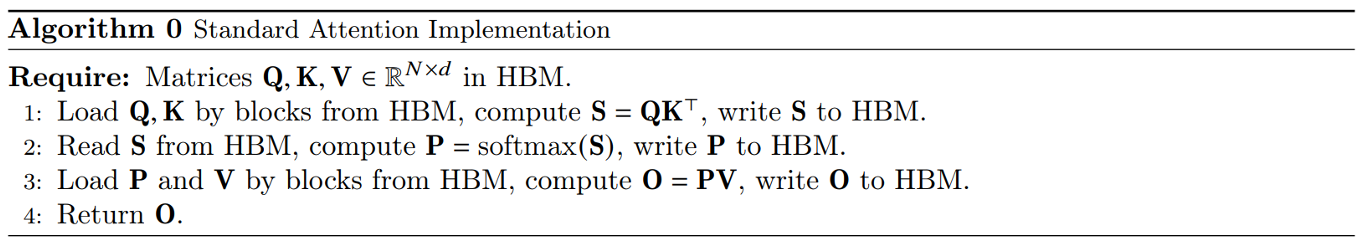

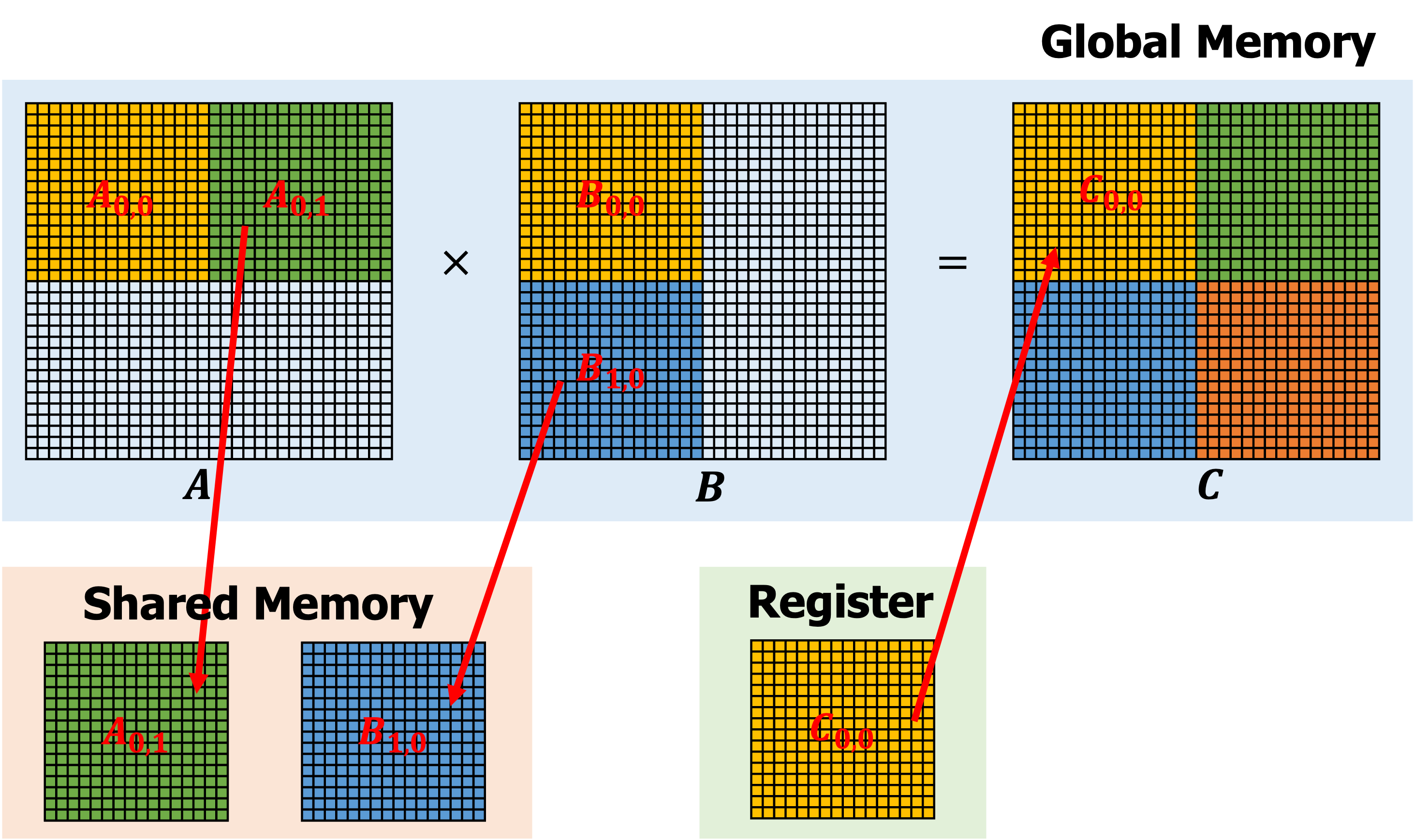

- 以矩阵乘法 𝑪=𝑨×𝑩 为例,在实际的计算过程中,线程会被组织成 block,再交由 SM 执行

- 以 𝑪 为 32*32 的矩阵,block 为 16*16 为例,一种朴素的实现方法:

- C 中每个位置的计算需要访问 global memory 2*32 次,总共 2*32*32*32 次

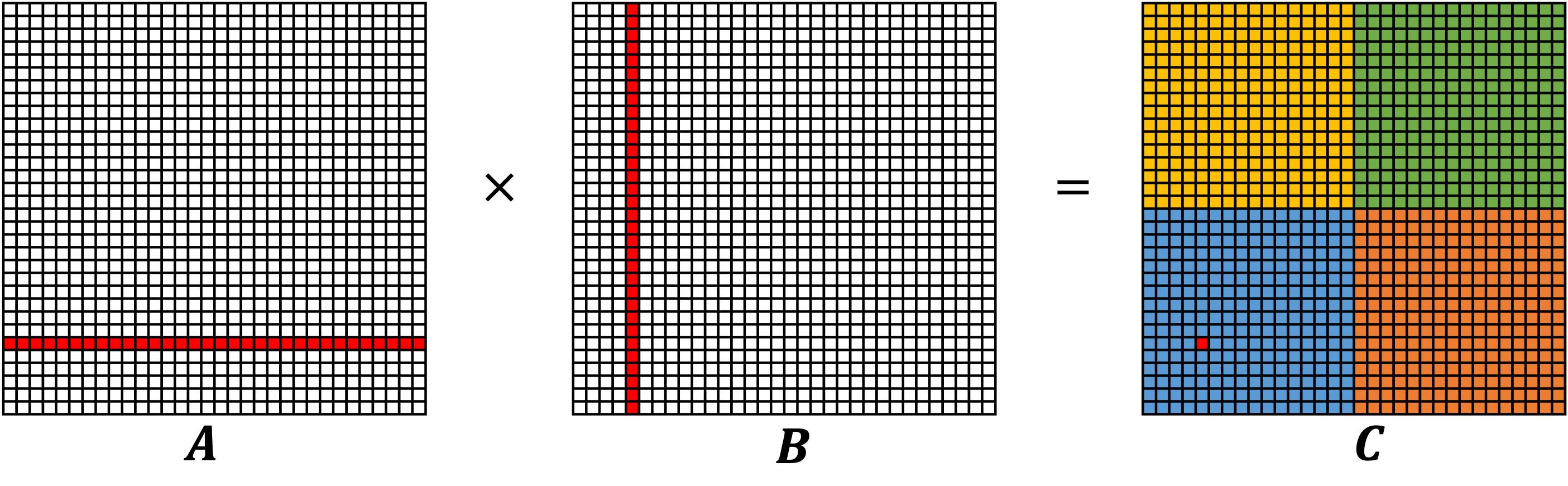

Tiling 技术

- 在朴素的实现方法中,我们并没有考虑利用 shared memory,而 Tiling 技术通过利用 shared memory 减少 global memory 的访问

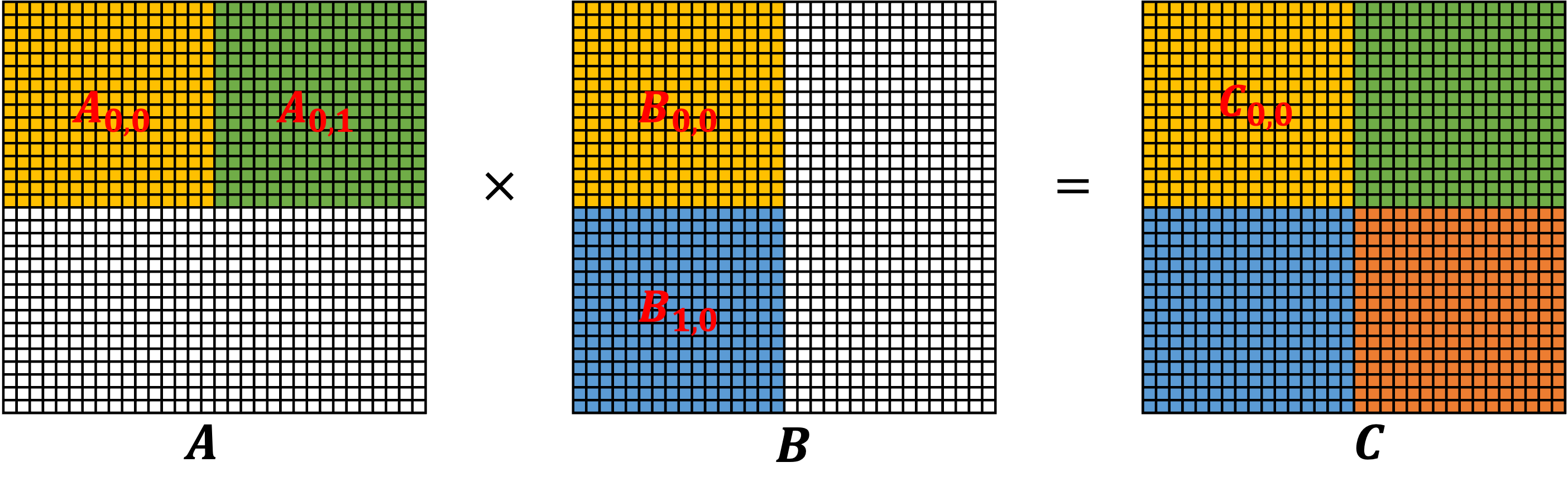

Tiling 技术 (cont'd)

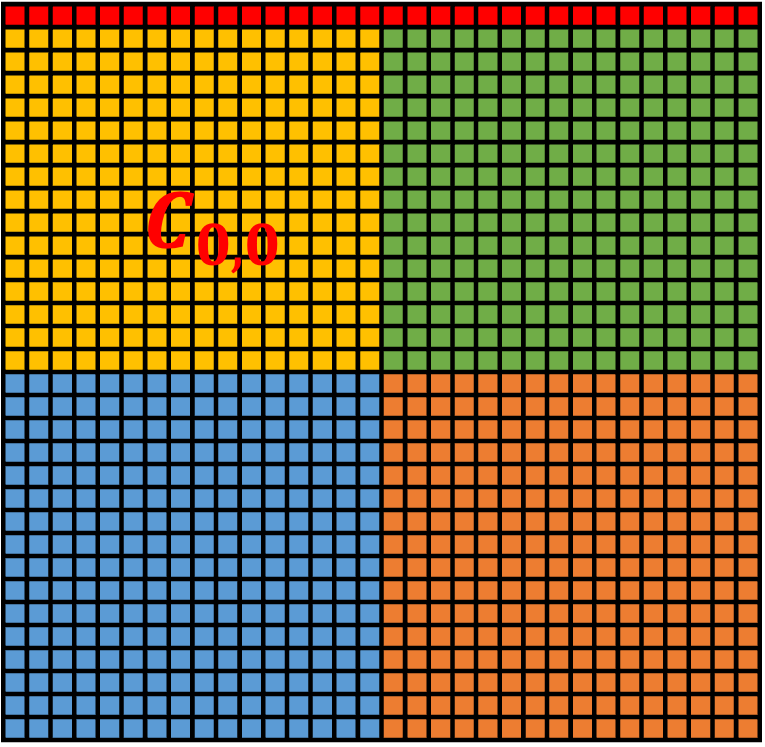

- 第一轮迭代存储角度图示:

Tiling 技术 (cont'd)

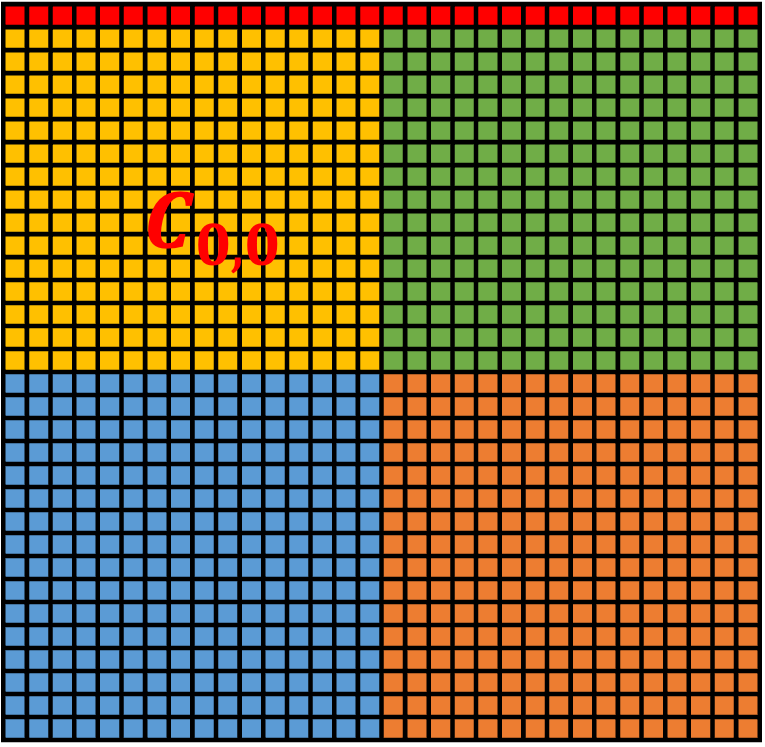

- 第二轮迭代存储角度图示:

Tiling 技术 (cont'd)

- 总计算量保持不变

- 但是总的 global memory 的访问次数大大降低,我们算出 C 矩阵四分之一的结果时,访问了 16*16*4 次 global memory,那么总共将访问 16*16*4*4 次,一共 4096 次;而之前 naive 的方法访问了 65536 次,减少为了原来的 1/16

- 调整 block 的大小还可以进一步改变 global memory 的访问次数

Unfortunately

- Tiling 技术虽然可用于矩阵乘法,但不能直接用于 Attention 的计算

- 在 Attention Layer 的计算中,存在一次 row-wise softmax 操作

- 在 Attention Layer 的计算中,存在一次 row-wise softmax 操作

- 在仅计算出

Unfortunately

- 因此 Tiling 技术仅仅减少了标准 Attention 算法中矩阵乘法的实际 global memory 访问次数,但是并没有从整体上改变标准 Attention 算法的流程

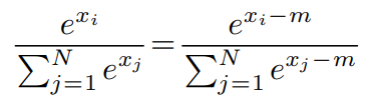

Safe Softmax

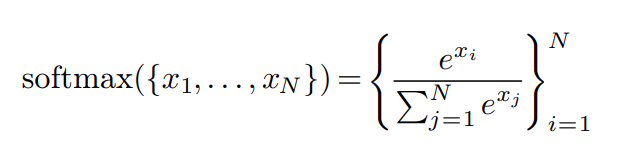

Softmax 的公式:

为了防止指数爆炸问题,在实际计算的时候会采用 Safe Softmax:

一般来说,上述公式中

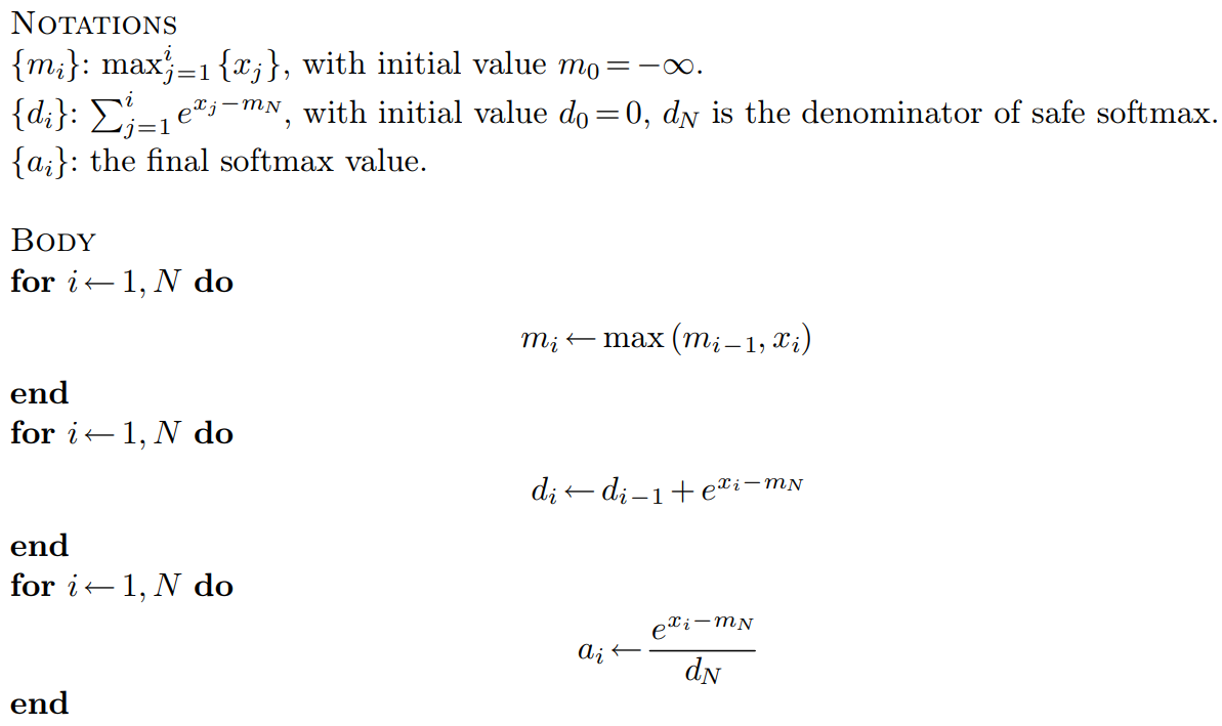

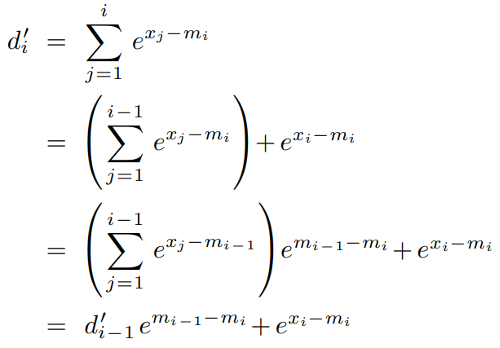

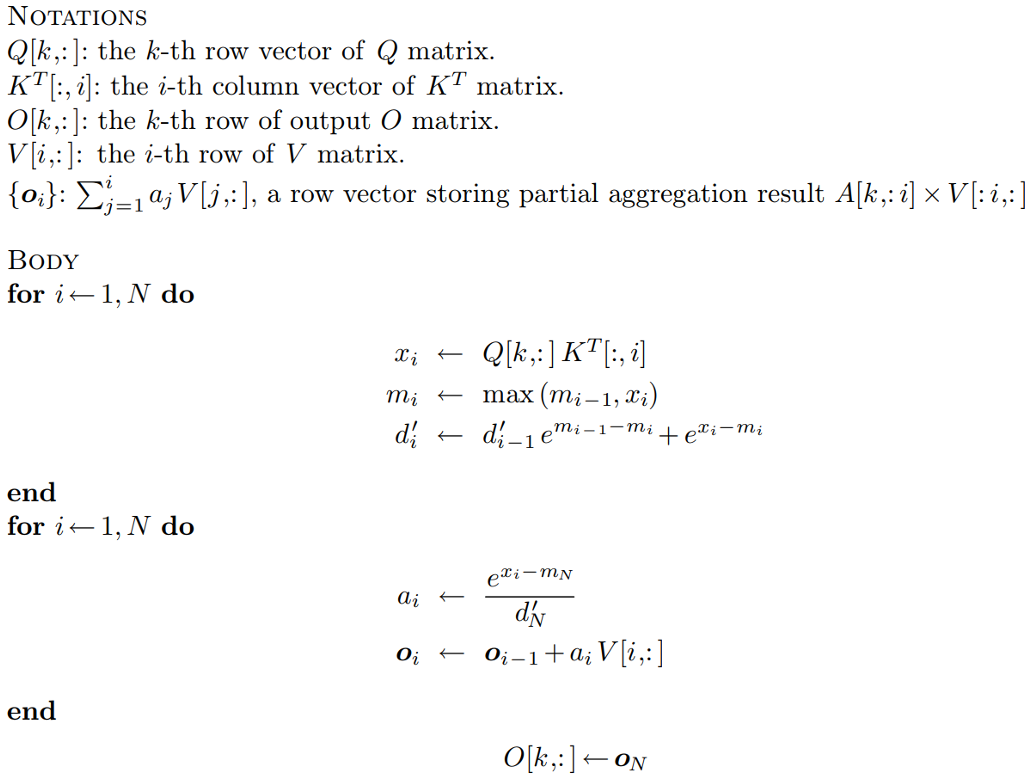

一种迭代式的 Safe Softmax 的算法(V1)

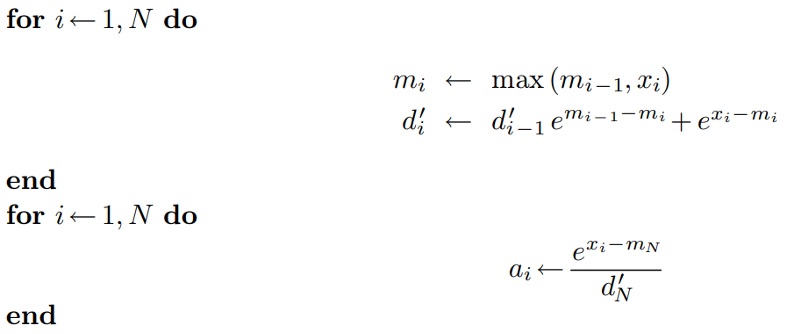

Online Softmax(V2)

- 优化思路:消除

Online Softmax(V2)

V2版本算法

Again, Unfortunately

- 以上优化对于 softmax 操作来说已经到头了,我们不可能在一次循环中把 softmax 的结果计算出来

- 原因:向量中的每个元素都是独立的,不可能在没有遍历到后续元素的情况下,确定当前元素最终的 softmax 值

But

- Attention Layer 的最终目的并不是为了计算 softmax,而是 softmax 以后的还需要乘以矩阵 V,得到最终的输出

一种 2-pass 的 Self Attention 的算法(V1)

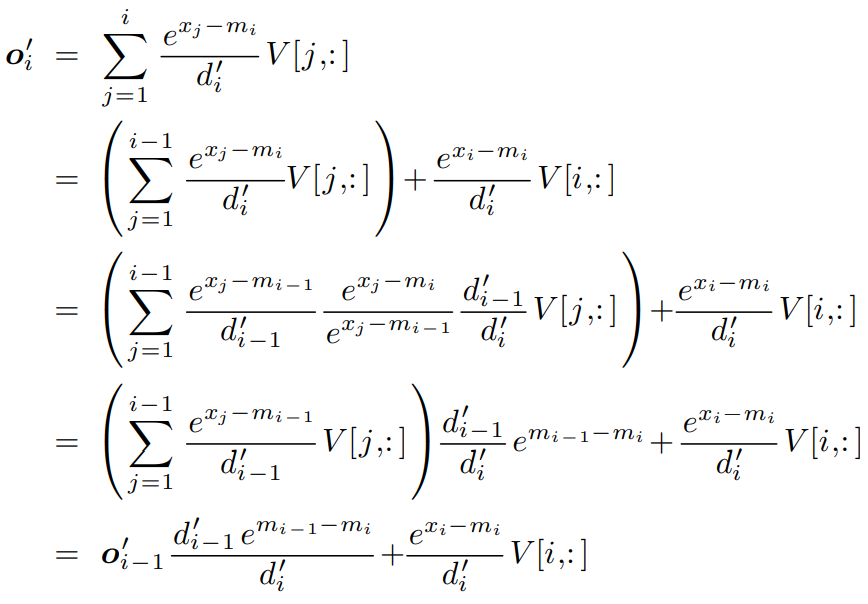

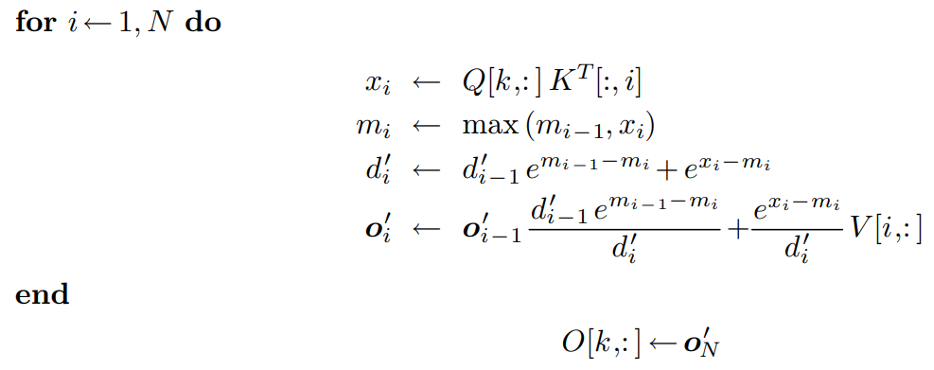

改良版的 1-pass 算法(V2)

改良版的 1-pass 算法(V2)(cont'd)

- 虽然 softmax 无法用 1-pass 的方式解决,但是 Self Attention 的计算可以用1-pass的方式解决

- 以上1-pass Self Attention 算法可看作 FlashAttention V1 的原型

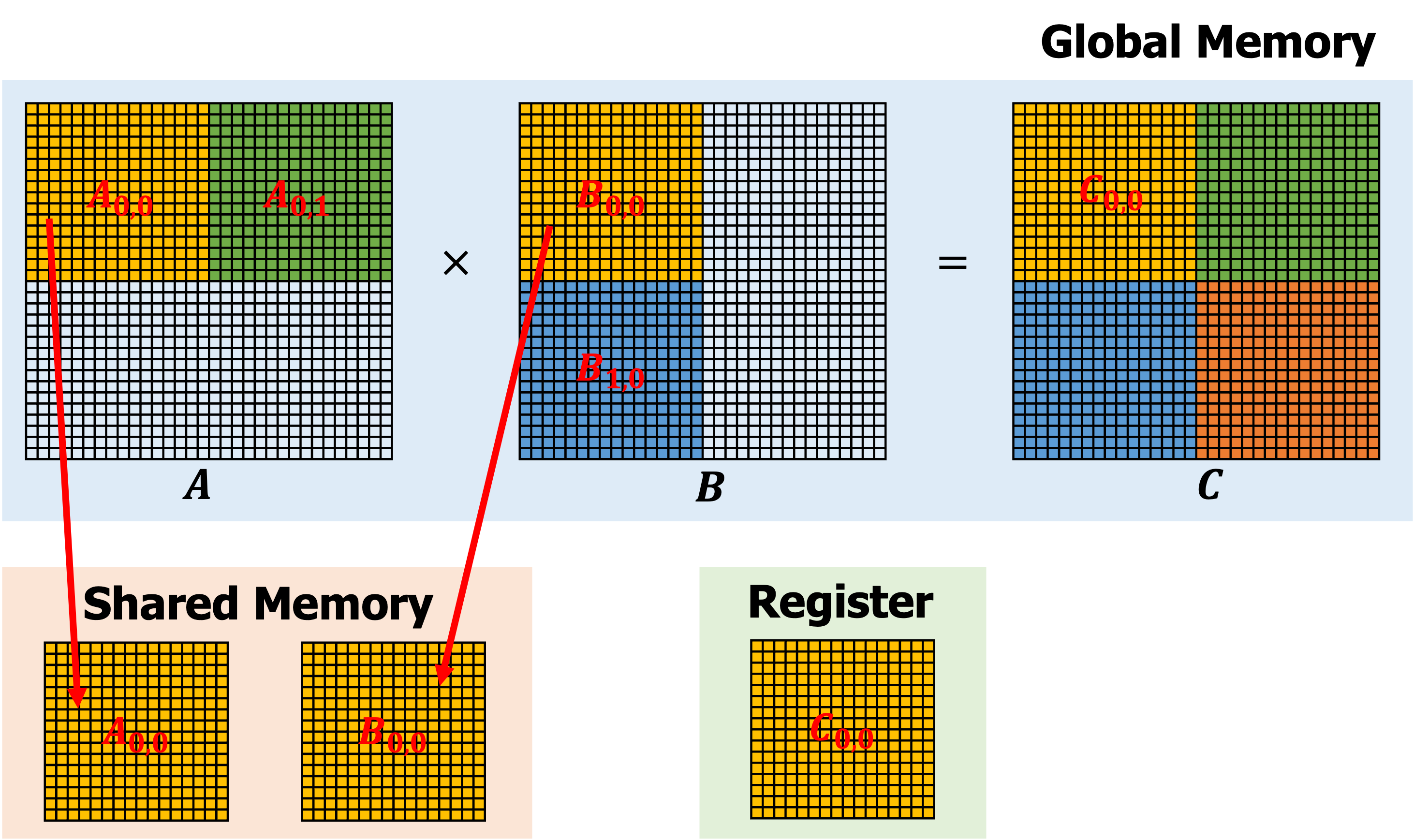

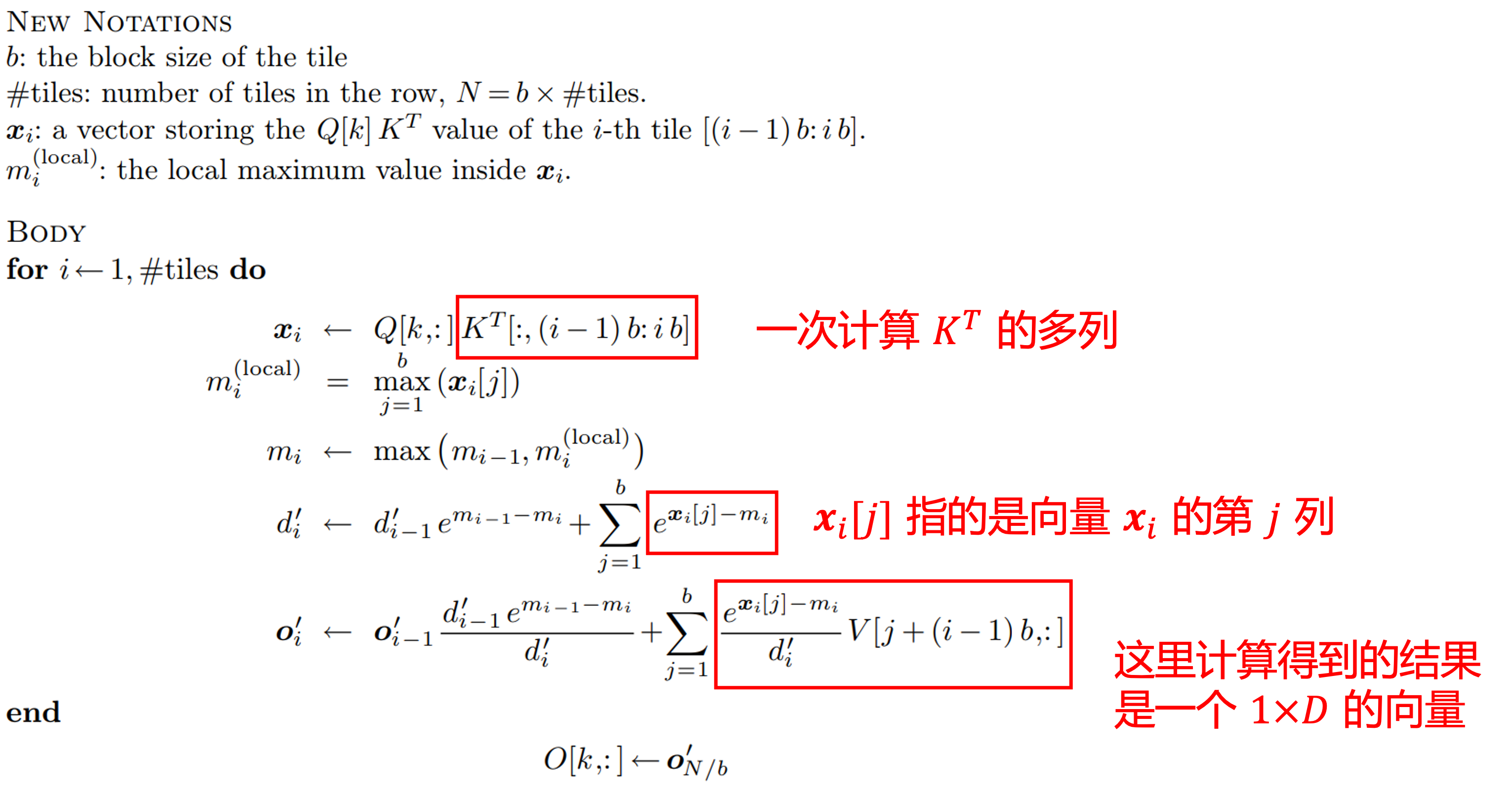

FlashAttention V1

- FlashAttention 在实现时,还考虑到了 Tiling 技术

FlashAttention V1

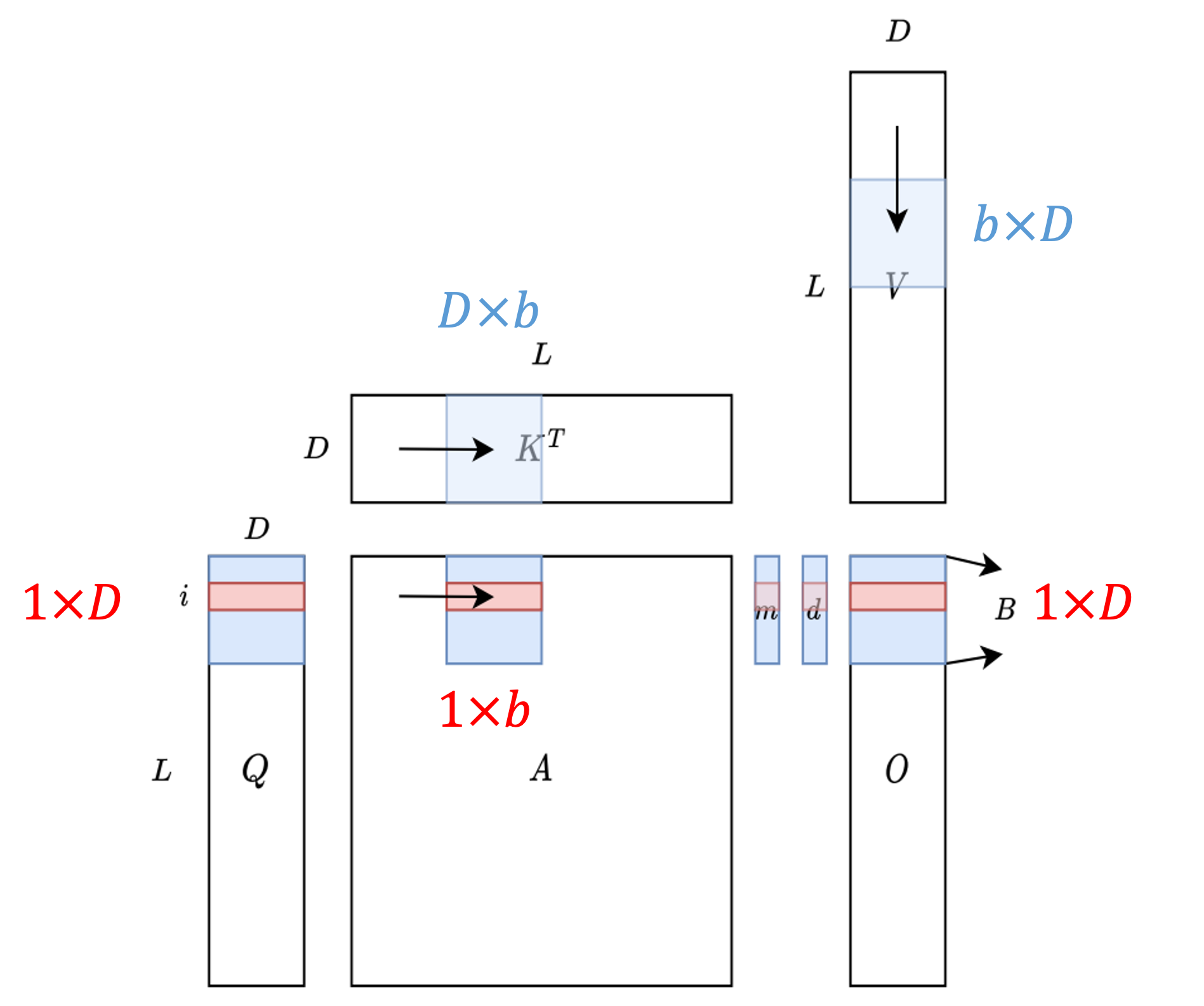

如下图所示,蓝色的部分表示当前存储在 shared memory 中的部分

FlashAttention 的实现是不唯一的,事实上,很多实现都没有完全采用原始论文中的方法,会有一定程度的调整

FlashAttention

- Installation

- GPU Basics

- FlashAttention V1

- FlashAttention V2

- Other

改进一:调整内外循环

- FlashAttention V1 中采用了一个非直觉的外层循环矩阵 𝐾,𝑉,内层循环矩阵 𝑄,𝑂 的方式,这会导致矩阵 𝑂 被额外加载

- 事实上,在 FlashAttention V2 出来之前,很多 FlashAttention 的实现就修改了这个循环顺序

改进二:减少了非矩阵乘法的运算次数

- 现代 GPU 对矩阵乘法有专门的硬件优化,矩阵乘法flop是非矩阵乘法flop的16倍左右

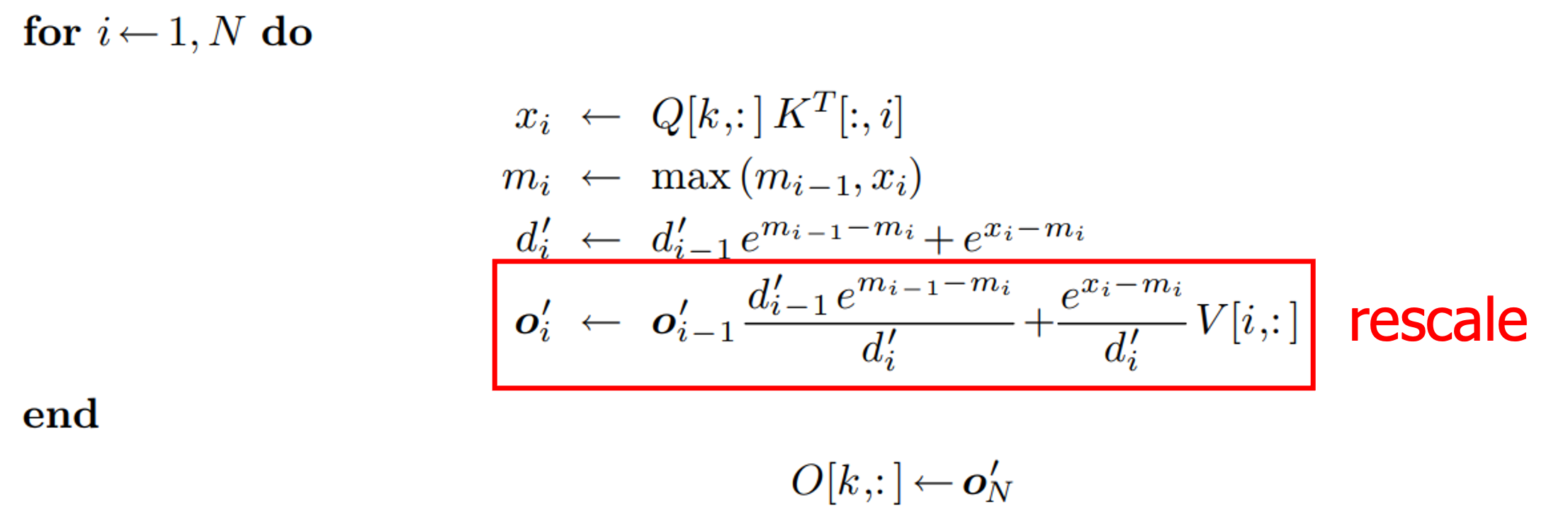

- 具体实现上,FlashAttention V1 每轮迭代都有一个 rescale 操作:

- 具体实现上,FlashAttention V1 每轮迭代都有一个 rescale 操作:

- 在 V2 中,不再在每轮迭代中都除以

改进三:Warp Level 并行度

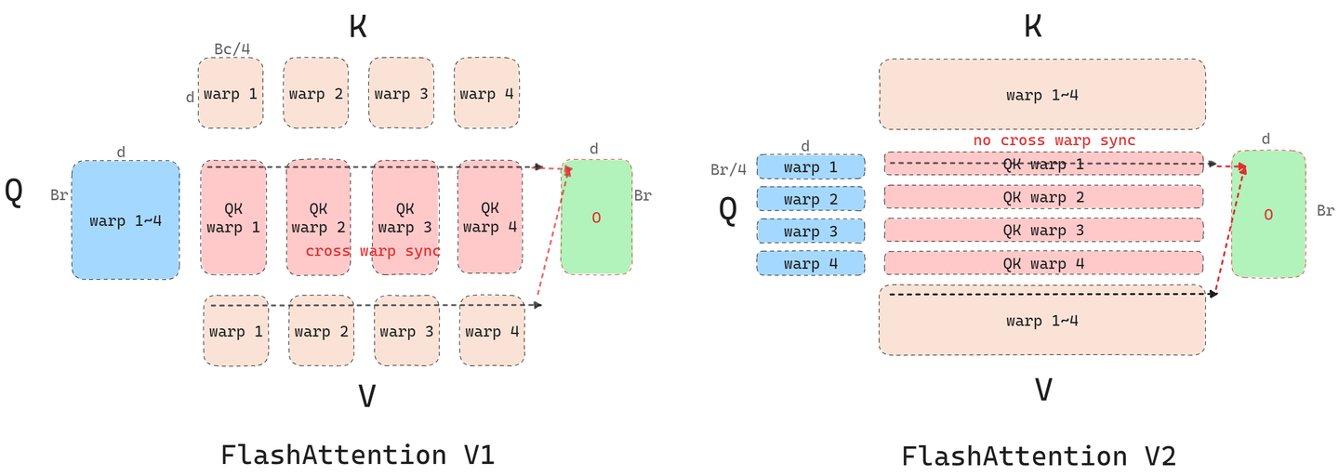

假设一个 block 实际上会被 SM 划分成 4 个 warp,在 V1 版本中,矩阵 𝐾,𝑉 的 block 会被划分成 4 个 warp,每个 warp 计算

改进三:Warp Level 并行度(cont'd)

在 V2 版本中,矩阵 𝑄 的 block 会被划分成 4 个 warp,这种情况下每个 warp 计算出来的结果就是一个

FlashAttention

- Installation

- GPU Basics

- FlashAttention V1

- FlashAttention V2

- Other

FlashAttention 使用途径

- 使用官方库 flash_attn,可以通过 pip 直接安装,这种方法如果需要做一些逻辑上的修改(例如加 mask),学习和 Debug 的成本较高

- 使用 Triton Language 中的实现,实际性能也很好